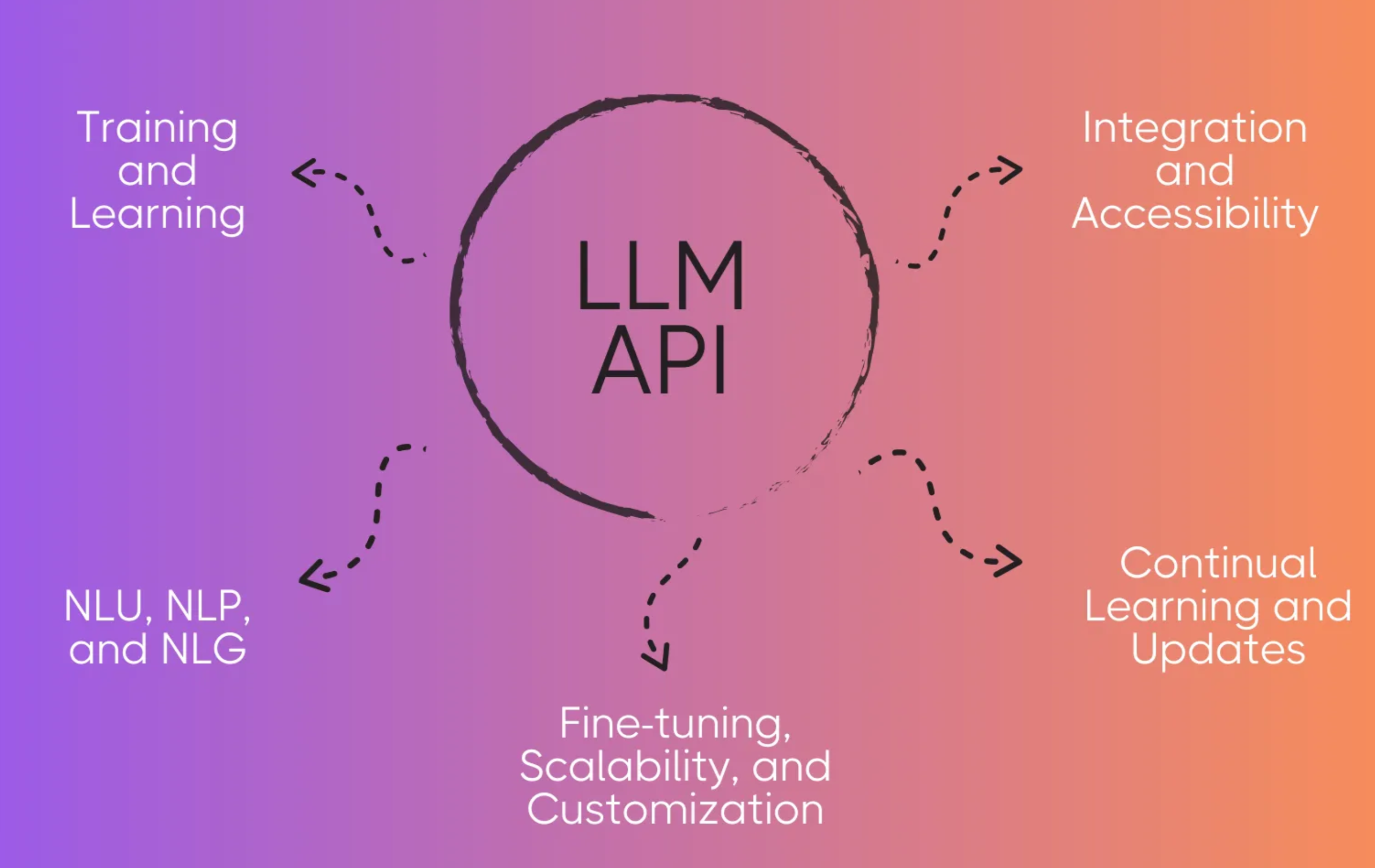

LLM - Prompt

Prompt

- 是否充分使用好 AI 大模型,提示是关键

- OpenAI

question / answer- prompt / completion - 给 LLM 一个提示,让 LLM 进行补全

- LLM 训练原理

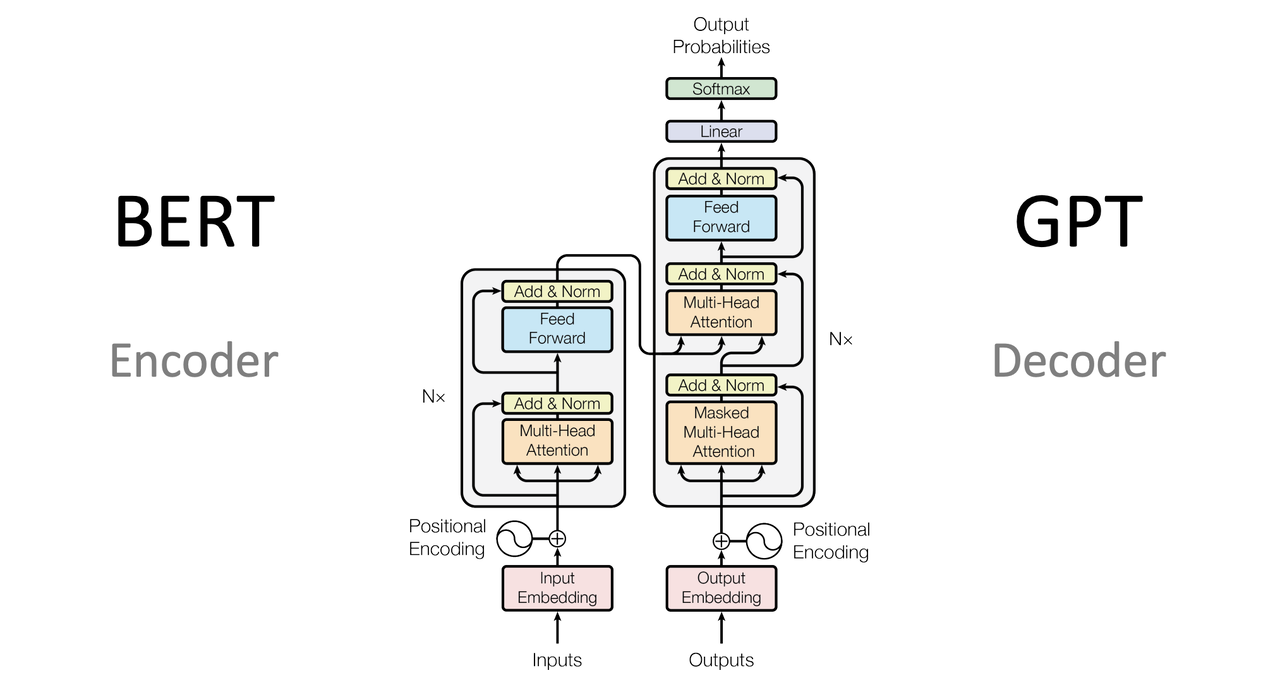

- GPT 系列模型基于

Transformer架构的解码器机制,使用自回归无监督方式进行预训练 - 训练过程 -

大量的文本输入,不断进行记忆 - 相比于监督学习,

训练效率更低,但训练过程简单,可以喂大量的文本语料,上限比较高

- GPT 系列模型基于

- completion

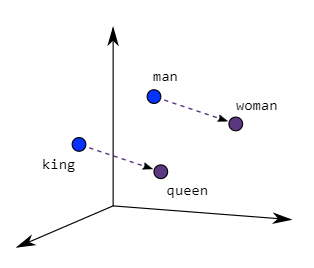

- 根据训练过的

记忆,一个字一个字地计算概率,取概率最大的那个字进行输出 - 因此有人吐槽 LLM 输出很慢 -

逐字计算并输出

- 根据训练过的

Prompt Engineering

- 需求描述越详细越准确,LLM 输出的内容就越符合要求

- Prompt Engineering 是一门专门研究与 LLM 交互的新型学科

- 通过不断地开发和优化,帮助用户更好地了解 LLM 的能力和局限性

- 探讨如何设计出

最佳提示,用于指导 LLM 帮助我们高效完成某项任务 - 不仅仅是设计和研发提示,还包含了与 LLM 交互的各种

技能和技术 - 在实现与 LLM 交互、对接,以及理解 LLM 能力方面都起着重要作用

- 用户可以通过 Prompt Engineering 来提高 LLM 的

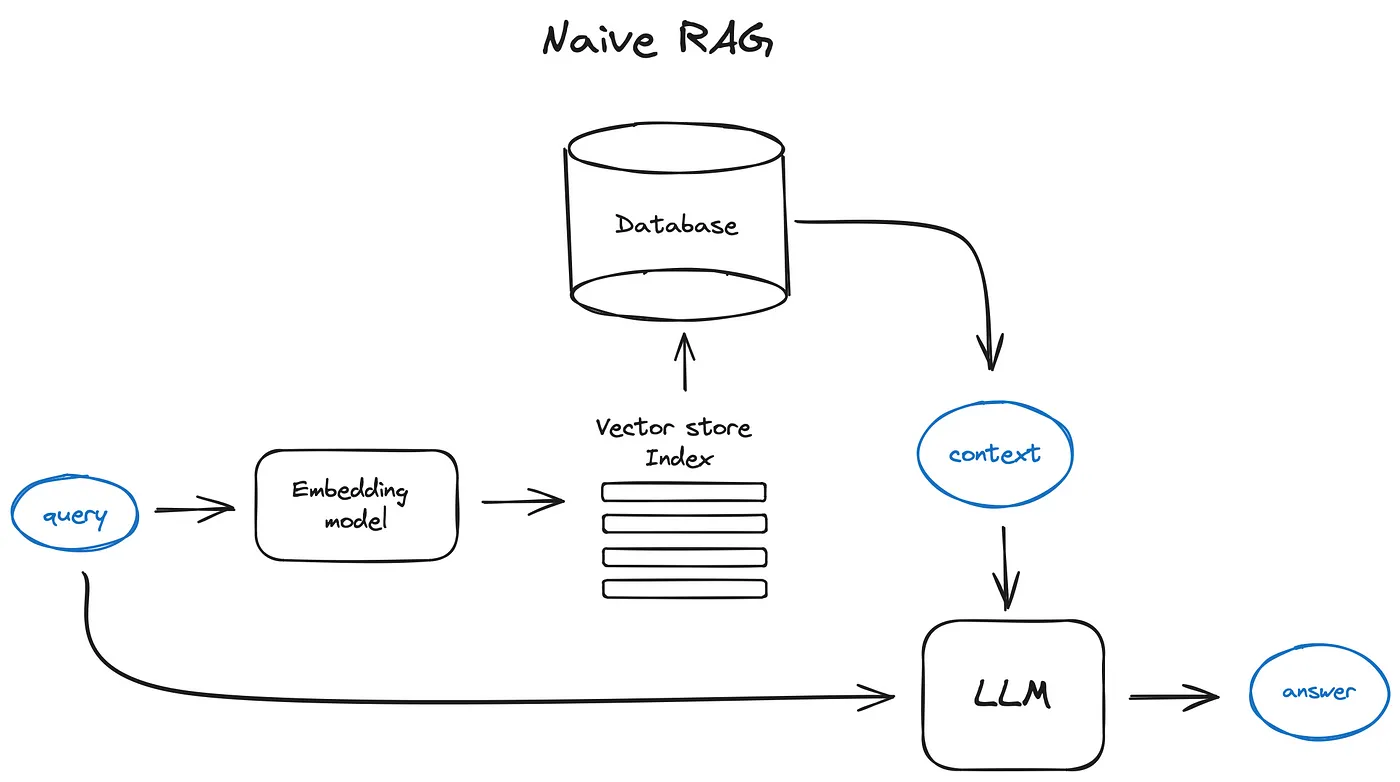

安全性- 也可以借助专业领域知识和外部工具来

增强LLM 的能力

- 也可以借助专业领域知识和外部工具来

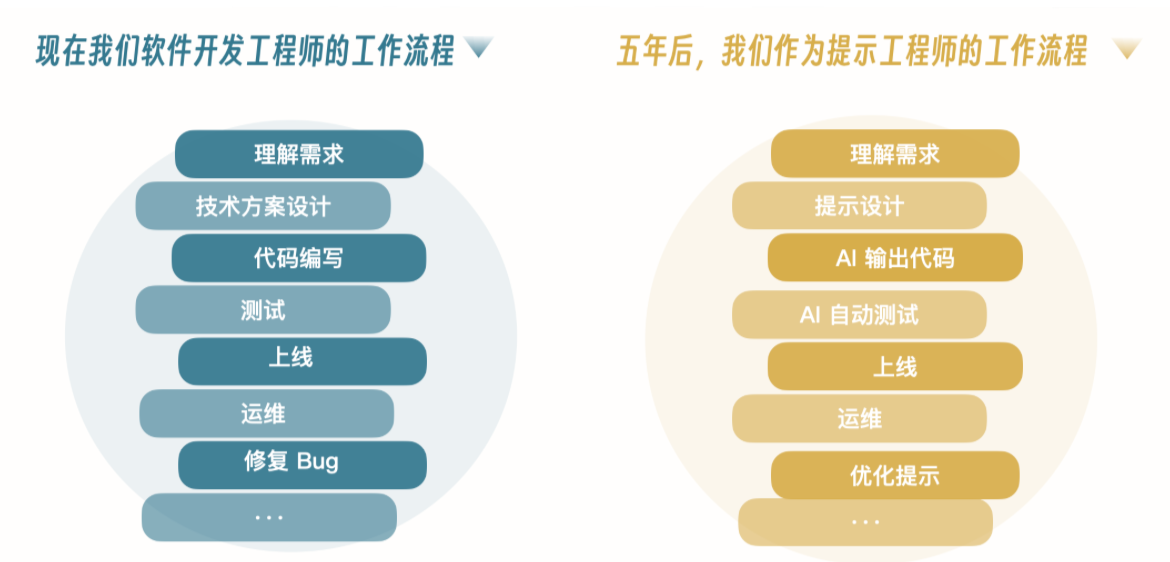

AI 领导力

Prompt 是我们与 LLM 沟通的唯一桥梁

构造 Prompt

获取好的输出结果

- 不断地与模型进行交互,输入很简单,通过

多轮问答,不断地对输出进行调整 一次性尽可能地将输入写好 -更推荐,这样 LLM 就不需要去理解上下文

提示 = 任务 + 上下文 + 范例 + 角色 + 格式 + 语气

| Item | Desc |

|---|---|

| 任务 | 从动作动词开始,无论简单还是复杂,都要明确说明目标,来有效指导输出 |

| 上下文 | 为 LLM 提供足够的背景信息,描述清楚用户环境,来缩小可能性,同时可以定义生成任务需要的步骤 |

| 示例 | 利用示例或框架可以显著提高简历、面试问题或职位描述等各种任务的输出质量 |

| 角色 | 定义 LLM 应该效仿的人,如技术专家、营养师等 |

| 格式 | 无论是表格、电子邮件、代码块、段落,还是期望的输出长度,可以把所需的输出格式可视化,来有效地适应任务 |

| 语气 | 指定所需的语气,指导 LLM 匹配写作风格 |

- 重要性排序 - 任务设定目标 > 上下文信息 > 范例 > 角色 > 格式结构输出 > 语气定义写作风格

- 一个好的提示不一定要包含所有模块,但最好要包括

任务和上下文- 尽可能详细地进行描述

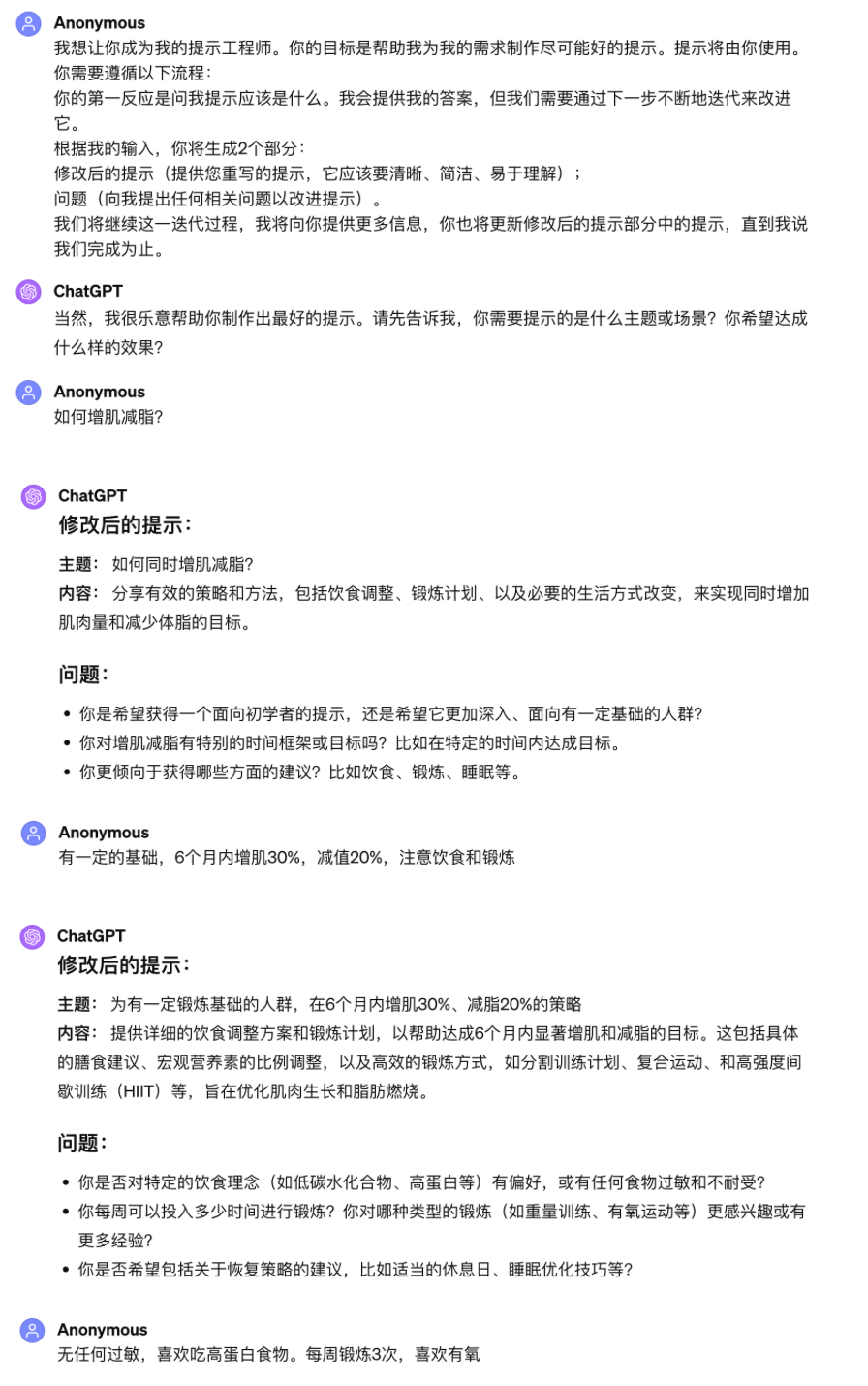

生成 Prompt 的 Prompt

ChatGPT - 持续迭代 Prompt

Workflow

All articles on this blog are licensed under CC BY-NC-SA 4.0 unless otherwise stated.