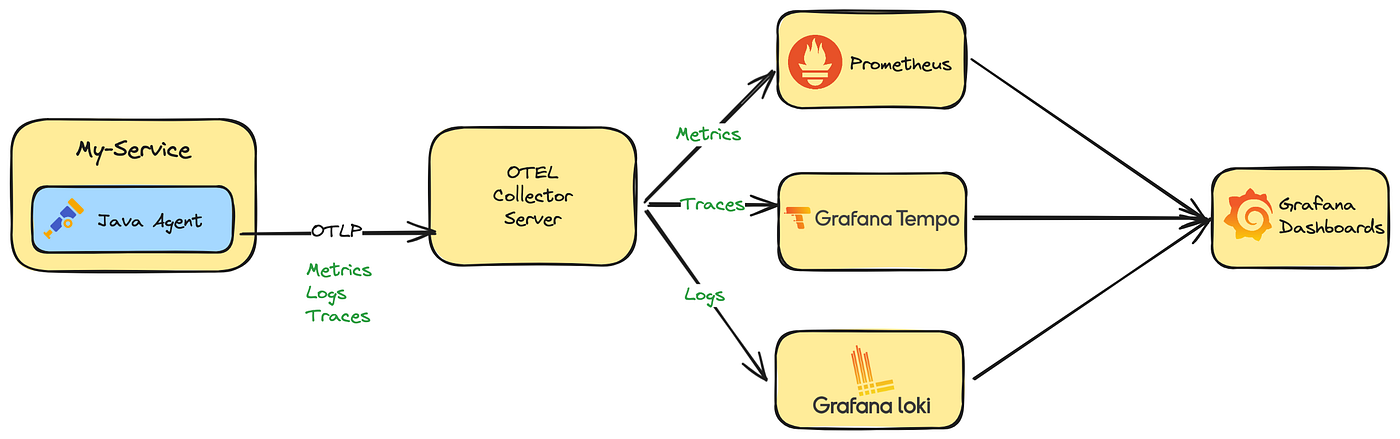

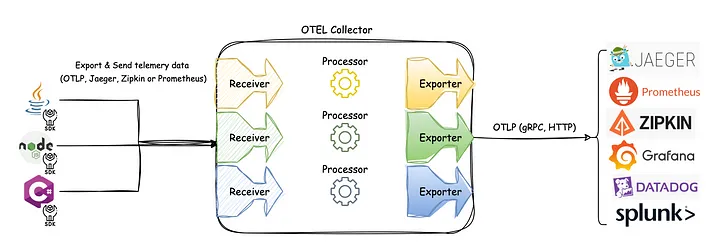

OpenTelemetry vs Prometheus 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 关系概述:互补为主,渐趋融合 OpenTelemetry 和 Prometheus 在指标领域主要是互补关系,而非冲突。两个项目都在积极合作以实现更好的互操作性。 1. 定位差异 Prometheus: - 完整的监控系统(采集、存储、查询、告警) - 专注于指标监控 - 拉模型(Pull-based)为主 - 拥有成熟的时序数据库和查询语言 PromQL OpenTelemetry: - 标准化的遥测数据收集框架 - 支持三大信号:指标、追踪、日志 - 推模型(Push-based)为主 - 不提供存储和查询后端 2. 技术模型对比 | 特性 | Prometheus | OpenTelemetry | |------|---------------------------------|-----------------------------------------------| | 数据模型 | 简单的时序数据模型 | 复杂的三层数据模型 | | 传输协议 | HTTP/文本格式 | OTLP(二进制协议) | | 指标类型 | Counter、Gauge、Histogram、Summary | Counter、Gauge、Histogram、Exponential Histogram | | 命名规范 | 下划线分隔(如 http_requests_total) | 点号分隔(如 http.requests.total) | | 数据收集 | Pull(拉取) | Push(推送) | 3. 兼容性发展历程 过去的挑战(Prometheus 2.0时代) - 命名规范不兼容 - 指标类型映射复杂 - 数据模型转换困难 现状的改善(Prometheus 3.0时代) - Prometheus 3.0 原生支持 OTLP 指标摄入 - UTF-8 标准化:支持点号命名,避免自动转换为下划线 - 双向转换:支持 Prometheus ↔ OpenTelemetry 数据转换 - 标准化规范:官方的互操作性规范 4. 集成模式 模式1:OpenTelemetry → Prometheus 应用程序 → OTel SDK → OTel Collector → Prometheus - 使用 OpenTelemetry Collector 作为桥梁 - 支持多种导出器:Prometheus Remote Write、Prometheus Exporter 模式2:Prometheus → OpenTelemetry 应用程序 → Prometheus Exporter → OTel Collector → 后端存储 - OTel Collector 充当 Prometheus Server 角色 - 抓取 Prometheus 格式指标并转换为 OTLP 模式3:混合部署 ┌─────────────────┐ │ OTel Collector │ └─────────┬───────┘ │ ┌──────────────┼──────────────┐ │ │ │ ┌────▼────┐ ┌─────▼─────┐ ┌───▼───┐ │Prometheus│ │其他OTLP后端│ │Grafana │ └─────────┘ └───────────┘ └───────┘ 5. 实际使用建议 选择 OpenTelemetry 的情况: - 需要统一的三信号观测(指标+追踪+日志) - 希望供应商中立的解决方案 - 需要更丰富的上下文关联 - 计划多云或混合云部署 选择 Prometheus 的情况: - 主要关注基础设施监控 - 已有成熟的 Prometheus 生态 - 需要 PromQL 的强大查询能力 - 团队对 Prometheus 更熟悉 混合使用的情况: - 利用 OpenTelemetry 进行应用观测 - 使用 Prometheus 进行基础设施监控 - 通过 OTel Collector 统一数据流 6. 未来发展趋势 1. 深度融合:Prometheus 3.0+ 将深度集成 OpenTelemetry 2. 标准统一:CNCF 推动统一的可观测性标准 3. 生态互补:两个项目继续发挥各自优势 4. 无缝迁移:提供平滑的迁移路径 总结 OpenTelemetry 和 Prometheus 的关系已经从早期的"冲突"转向"互补和融合"。它们不是竞争关系,而是: - 互补关系:OpenTelemetry 提供标准化的数据收集,Prometheus 提供强大的存储和查询 - 融合趋势:Prometheus 3.0+ 原生支持 OpenTelemetry,两个生态系统正在深度整合 - 最佳实践:根据具体需求选择合适的组合方案 对于新项目,建议采用 OpenTelemetry 进行标准化观测,同时可以选择 Prometheus 作为后端存储之一,实现灵活性和兼容性的平衡。

Getting started

This guide is a “Hello World “-style tutorial which shows how to install , configure , and use a simple Prometheus instance .

You will download and run Prometheus locally

configure it to scrape itself and an example application , then work with queries , rules , and graphs to use collected time series data .

Downloading and running Prometheus Download the latest release of Prometheus for your platform, then extract and run it:

1 2 tar xvfz prometheus-*.tar.gz cd prometheus-*

Before starting Prometheus, let’s configure it.

Configuring Prometheus to monitor itself

Prometheus collects metrics from targets by scraping metrics HTTP endpoints .

Since Prometheus exposes data in the same manner about itself, it can also scrape and monitor its own health .

While a Prometheus server that collects only data about itself is not very useful, it is a good starting example.

Save the following basic Prometheus configuration as a file named prometheus.yml:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 global: scrape_interval: 15s external_labels: monitor: 'codelab-monitor' scrape_configs: - job_name: 'prometheus' scrape_interval: 5s static_configs: - targets: ['localhost:9090' ]

Starting Prometheus To start Prometheus with your newly created configuration file, change to the directory containing the Prometheus binary and run:

1 2 3 # Start Prometheus. # By default, Prometheus stores its database in ./data (flag --storage.tsdb.path). ./prometheus --config.file=prometheus.yml

Prometheus should start up . You should also be able to browse to a status page about itself at localhost:9090 .

Give it a couple of seconds to collect data about itself from its own HTTP metrics endpoint .

You can also verify that Prometheus is serving metrics about itself by navigating to its metrics endpoint: localhost:9090/metrics

Using the expression browser

Let us explore data that Prometheus has collected about itself.

To use Prometheus’s built-in expression browser , navigate to http://localhost:9090/query and choose the “Graph “ tab.

As you can gather from localhost:9090/metrics

one metric that Prometheus exports about itself is named prometheus_target_interval_length_seconds

the actual amount of time between target scrapes

Enter the below into the expression console and then click “Execute “:

1 prometheus_target_interval_length_seconds

This should return a number of different time series (along with the latest value recorded for each)

each with the metric name prometheus_target_interval_length_seconds , but with different labels .

These labels designate different latency percentiles and target group intervals .

If we are interested only in 99th percentile latencies , we could use this query:

1 prometheus_target_interval_length_seconds{quantile="0.99"}

To count the number of returned time series , you could write:

1 count(prometheus_target_interval_length_seconds)

Using the graphing interface

To graph expressions, navigate to http://localhost:9090/query and use the “Graph “ tab.

For example, enter the following expression to graph the per-second rate of chunks being created in the self-scraped Prometheus:

Starting up some sample targets

Let’s add additional targets for Prometheus to scrape.

The Node Exporter is used as an example target

1 2 3 4 5 6 7 tar -xzvf node_exporter-*.*.tar.gz cd node_exporter-*.* # Start 3 example targets in separate terminals: ./node_exporter --web.listen-address 127.0.0.1:8080 ./node_exporter --web.listen-address 127.0.0.1:8081 ./node_exporter --web.listen-address 127.0.0.1:8082

You should now have example targets listening on http://localhost:8080/metrics , http://localhost:8081/metrics , and http://localhost:8082/metrics .

Now we will configure Prometheus to scrape these new targets.

Let’s group all three endpoints into one job called node .

We will imagine that the first two endpoints are production targets, while the third one represents a canary instance.

To model this in Prometheus, we can add several groups of endpoints to a single job , adding extra labels to each group of targets.

In this example, we will add the group=”production” label to the first group of targets, while adding group=”canary” to the second.

To achieve this, add the following job definition to the scrape_configs section in your prometheus.yml and restart your Prometheus instance:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 scrape_configs: - job_name: 'node' scrape_interval: 5s static_configs: - targets: ['localhost:8080' , 'localhost:8081' ] labels: group: 'production' - targets: ['localhost:8082' ] labels: group: 'canary'

Go to the expression browser and verify that Prometheus now has information about time series that these example endpoints expose, such as node_cpu_seconds_total .

Though not a problem in our example, queries that aggregate over thousands of time series can get slow when computed ad-hoc .

To make this more efficient , Prometheus can prerecord expressions into new persisted time series via configured recording rules .

Let’s say we are interested in recording the per-second rate of cpu time (node_cpu_seconds_total) averaged over all cpus per instance (but preserving the job , instance and mode dimensions) as measured over a window of 5 minutes. We could write this as:

1 avg by (job, instance, mode) (rate(node_cpu_seconds_total[5m]))

To record the time series resulting from this expression into a new metric called job_instance_mode:node_cpu_seconds:avg_rate5m

create a file with the following recording rule and save it as prometheus.rules.yml:

1 2 3 4 5 groups: - name: cpu-node rules: - record: job_instance_mode:node_cpu_seconds:avg_rate5m expr: avg by (job, instance, mode) (rate(node_cpu_seconds_total[5m]))

To make Prometheus pick up this new rule , add a rule_files statement in your prometheus.yml.

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 global: scrape_interval: 15s evaluation_interval: 15s external_labels: monitor: "codelab-monitor" rule_files: - "prometheus.rules.yml" scrape_configs: - job_name: "prometheus" scrape_interval: 5s static_configs: - targets: ["localhost:9090" ] - job_name: "node" scrape_interval: 5s static_configs: - targets: ["localhost:8080" , "localhost:8081" ] labels: group: "production" - targets: ["localhost:8082" ] labels: group: "canary"

Restart Prometheus with the new configuration and verify that a new time series with the metric name job_instance_mode:node_cpu_seconds:avg_rate5m is now available by querying it through the expression browser or graphing it.

Reloading configuration

As mentioned in the configuration documentation

a Prometheus instance can have its configuration reloaded without restarting the process by using the SIGHUP signal.

If you’re running on Linux this can be performed by using kill -s SIGHUP <PID>, replacing <PID> with your Prometheus process ID.

1 2 time=2025-11-08T23:45:43.274+08:00 level=INFO source=main.go:1502 msg="Loading configuration file" filename=prometheus.yml time=2025-11-08T23:45:44.438+08:00 level=INFO source=main.go:1542 msg="Completed loading of configuration file" db_storage=2.959µs remote_storage=2.083µs web_handler=1.5µs query_engine=2.041µs scrape=1.163449209s scrape_sd=52.666µs notify=1.375µs notify_sd=792ns rules=340.792µs tracing=3.833µs filename=prometheus.yml totalDuration=1.164344791s

Shutting down your instance gracefully.

While Prometheus does have recovery mechanisms in the case that there is an abrupt process failure

it is recommended to use signals or interrupts for a clean shutdown of a Prometheus instance .

On Linux , this can be done by sending the SIGTERM or SIGINT signals to the Prometheus process .

For example, you can use kill -s <SIGNAL> <PID>, replacing <SIGNAL> with the signal name and <PID> with the Prometheus process ID .

Alternatively, you can press the interrupt character at the controlling terminal , which by default is ^C (Control-C).

SIGTERM

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 time=2025-11-08T23:49:48.337+08:00 level=WARN source=main.go:1080 msg="Received an OS signal, exiting gracefully..." signal=terminated time=2025-11-08T23:49:48.337+08:00 level=INFO source=main.go:1105 msg="Stopping scrape discovery manager..." time=2025-11-08T23:49:48.337+08:00 level=INFO source=main.go:1119 msg="Stopping notify discovery manager..." time=2025-11-08T23:49:48.337+08:00 level=INFO source=manager.go:204 msg="Stopping rule manager..." component="rule manager" time=2025-11-08T23:49:48.338+08:00 level=INFO source=manager.go:220 msg="Rule manager stopped" component="rule manager" time=2025-11-08T23:49:48.338+08:00 level=INFO source=main.go:1156 msg="Stopping scrape manager..." time=2025-11-08T23:49:48.338+08:00 level=INFO source=main.go:1101 msg="Scrape discovery manager stopped" time=2025-11-08T23:49:48.338+08:00 level=INFO source=main.go:1148 msg="Scrape manager stopped" time=2025-11-08T23:49:48.338+08:00 level=INFO source=main.go:1115 msg="Notify discovery manager stopped" time=2025-11-08T23:49:48.348+08:00 level=INFO source=manager.go:559 msg="Stopping notification manager..." component=notifier time=2025-11-08T23:49:48.348+08:00 level=INFO source=manager.go:301 msg="Draining any remaining notifications..." component=notifier time=2025-11-08T23:49:48.348+08:00 level=INFO source=manager.go:307 msg="Remaining notifications drained" component=notifier time=2025-11-08T23:49:48.348+08:00 level=INFO source=manager.go:234 msg="Notification manager stopped" component=notifier time=2025-11-08T23:49:48.348+08:00 level=INFO source=main.go:1426 msg="Notifier manager stopped" time=2025-11-08T23:49:48.349+08:00 level=INFO source=main.go:1440 msg="See you next time!"

SIGINT

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 time=2025-11-08T23:50:52.014+08:00 level=WARN source=main.go:1080 msg="Received an OS signal, exiting gracefully..." signal=interrupt time=2025-11-08T23:50:52.014+08:00 level=INFO source=main.go:1105 msg="Stopping scrape discovery manager..." time=2025-11-08T23:50:52.014+08:00 level=INFO source=main.go:1119 msg="Stopping notify discovery manager..." time=2025-11-08T23:50:52.014+08:00 level=INFO source=manager.go:204 msg="Stopping rule manager..." component="rule manager" time=2025-11-08T23:50:52.014+08:00 level=INFO source=manager.go:220 msg="Rule manager stopped" component="rule manager" time=2025-11-08T23:50:52.014+08:00 level=INFO source=main.go:1156 msg="Stopping scrape manager..." time=2025-11-08T23:50:52.014+08:00 level=INFO source=main.go:1115 msg="Notify discovery manager stopped" time=2025-11-08T23:50:52.014+08:00 level=INFO source=main.go:1148 msg="Scrape manager stopped" time=2025-11-08T23:50:52.014+08:00 level=INFO source=main.go:1101 msg="Scrape discovery manager stopped" time=2025-11-08T23:50:52.028+08:00 level=INFO source=manager.go:559 msg="Stopping notification manager..." component=notifier time=2025-11-08T23:50:52.028+08:00 level=INFO source=manager.go:301 msg="Draining any remaining notifications..." component=notifier time=2025-11-08T23:50:52.028+08:00 level=INFO source=manager.go:307 msg="Remaining notifications drained" component=notifier time=2025-11-08T23:50:52.028+08:00 level=INFO source=manager.go:234 msg="Notification manager stopped" component=notifier time=2025-11-08T23:50:52.028+08:00 level=INFO source=main.go:1426 msg="Notifier manager stopped" time=2025-11-08T23:50:52.028+08:00 level=INFO source=main.go:1440 msg="See you next time!"

Installation Using Docker

All Prometheus services are available as Docker images on Quay.io or Docker Hub

Running Prometheus on Docker is as simple as docker run -p 9090:9090 prom/prometheus .

This starts Prometheus with a sample configuration and exposes it on port 9090 .

The Prometheus image uses a volume to store the actual metrics .

For production deployments it is highly recommended to use a named volume to ease managing the data on Prometheus upgrades .

Setting command line parameters

The Docker image is started with a number of default command line parameters , which can be found in the Dockerfile .

If you want to add extra command line parameters to the docker run command , you will need to re-add these yourself as they will be overwritten .

Volumes & bind-mount

To provide your own configuration, there are several options. Here are two examples.

Bind-mount your prometheus.yml from the host by running:

1 2 3 4 docker run \ -p 9090:9090 \ -v /path/to/prometheus.yml:/etc/prometheus/prometheus.yml \ prom/prometheus

Or bind-mount the directory containing prometheus.yml onto /etc/prometheus by running:

1 2 3 4 docker run \ -p 9090:9090 \ -v /path/to/config:/etc/prometheus \ prom/prometheus

Save your Prometheus data

Prometheus data is stored in /prometheus dir inside the container , so the data is cleared every time the container gets restarted .To save your data, you need to set up persistent storage (or bind mounts ) for your container .

Run Prometheus container with persistent storage :

1 2 3 4 5 6 7 8 # Create persistent volume for your data docker volume create prometheus-data # Start Prometheus container docker run \ -p 9090:9090 \ -v /path/to/prometheus.yml:/etc/prometheus/prometheus.yml \ -v prometheus-data:/prometheus \ prom/prometheus

Configuration Configuration

Prometheus is configured via command-line flags and a configuration file .

While the command-line flags configure immutable system parameters

such as storage locations , amount of data to keep on disk and in memory, etc.

the configuration file defines everything related to scraping jobs and their instances , as well as which rule files to load .

To view all available command-line flags , run ./prometheus -h .

Prometheus can reload its configuration at runtime .

If the new configuration is not well-formed , the changes will not be applied .

A configuration reload is triggered by sending a SIGHUP to the Prometheus process

or sending a HTTP POST request to the /-/reload endpoint (when the –web.enable-lifecycle flag is enabled).

This will also reload any configured rule files .

Configuration file

To specify which configuration file to load, use the –config.file flag.

The file is written in YAML format, defined by the scheme described below.

Brackets indicate that a parameter is optional .For non-list parameters the value is set to the specified default .

Generic placeholders are defined as follows:

Key

Value

<boolean>a boolean that can take the values true or false

<duration>a duration matching the regular expression `((([0-9]+)y)?(([0-9]+)w)?(([0-9]+)d)?(([0-9]+)h)?(([0-9]+)m)?(([0-9]+)s)?(([0-9]+)ms)?

<filename>a valid path in the current working directory

<float>a floating-point number

<host>a valid string consisting of a hostname or IP followed by an optional port number

<int>an integer value

<labelname>a string matching the regular expression [a-zA-Z_][a-zA-Z0-9_]*.unsupported character in the source label should be converted to an underscore .app.kubernetes.io/name should be written as app_kubernetes_io_name.

<labelvalue>a string of unicode characters

<path>a valid URL path

<scheme>a string that can take the values http or https

<secret>a regular string that is a secret, such as a password

<string>a regular string

<size>a size in bytes, e.g. 512MB. A unit is required. Supported units: B, KB, MB, GB, TB, PB, EB.

<tmpl_string>a string which is template-expanded before usage

The other placeholders are specified separately .

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 🔍 占位符含义 基础数据类型 - <boolean>: 布尔值 - true 或 false - <string>: 普通字符串 - <int>: 整数值 - <float>: 浮点数 - <secret>: 敏感信息(如密码) 时间相关 - <duration>: 持续时间格式 - 支持: 1d, 1h30m, 5m, 10s - 正则: (([0-9]+)y)?(([0-9]+)w)?(([0-9]+)d)?(([0-9]+)h)?(([0-9]+)m)?(([0-9]+)s)?(([0-9]+)ms)? - 示例: 1d30m, 2h, 0 网络相关 - <host>: 主机名或IP + 可选端口 - 示例: localhost:9090, 192.168.1.1, example.com:8080 - <scheme>: 协议 - http 或 https - <path>: URL路径 标签相关 - <labelname>: 标签名称 - 规则: [a-zA-Z_][a-zA-Z0-9_]* - 特殊字符转换: app.kubernetes.io/name → app_kubernetes_io_name - <labelvalue>: 标签值(Unicode字符串) 文件相关 - <filename>: 当前工作目录下的有效路径 - <size>: 大小(字节) - 示例: 512MB, 1GB, 2TB - 单位: B, KB, MB, GB, TB, PB, EB 特殊类型 - <tmpl_string>: 模板字符串(使用前会展开) 📖 为什么需要这些定义? 1. 统一语法规范 # 这些都符合 <duration> 格式 scrape_interval: 1m evaluation_interval: 30s scrape_timeout: 10s 2. 避免歧义 # 明确哪些字段需要哪种格式 port: 9090 # <int> body_size_limit: 100MB # <size> timeout: 30s # <duration> 3. 标签标准化 # Kubernetes 标签转换规则 labels: app_kubernetes_io_name: "my-app" # 正确 app.kubernetes.io/name: "my-app" # 错误,需要转换 🎯 "The other placeholders are specified separately" 这句话的意思是: - 上面列出的是通用占位符 - 特定功能模块的占位符在各自的章节中定义 例如: # 在 <relabel_config> 章节会定义 <relabel_action>: replace | keep | drop | ... # 在 <kubernetes_sd_config> 章节会定义 <kubernetes_role>: node | service | pod | endpoints | ... 💡 实际应用 理解这些占位符能帮助你: 1. 正确编写配置文件 2. 快速理解配置文档 3. 避免常见的配置错误 比如看到配置文档中的: [ scrape_interval: <duration> | default = 1m ] 你就知道这里可以填入:30s, 5m, 1h 等时间格式。

The global configuration specifies parameters that are valid in all other configuration contexts .defaults for other configuration sections.

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 global: [ scrape_interval: <duration> | default = 1m ] [ scrape_timeout: <duration> | default = 10s ] [ scrape_protocols: [<string> , ... ] | default = [ OpenMetricsText1.0.0 , OpenMetricsText0.0.1 , PrometheusText0.0.4 ] ] [ evaluation_interval: <duration> | default = 1m ] [ rule_query_offset: <duration> | default = 0s ] external_labels: [ <labelname>: <labelvalue> ... ] [ query_log_file: <string> ] [ scrape_failure_log_file: <string> ] [ body_size_limit: <size> | default = 0 ] [ sample_limit: <int> | default = 0 ] [ label_limit: <int> | default = 0 ] [ label_name_length_limit: <int> | default = 0 ] [ label_value_length_limit: <int> | default = 0 ] [ target_limit: <int> | default = 0 ] [ keep_dropped_targets: <int> | default = 0 ] [ metric_name_validation_scheme: <string> | default "utf8" ] [ convert_classic_histograms_to_nhcb: <bool> | default = false ] [ always_scrape_classic_histograms: <boolean> | default = false ] runtime: [ gogc: <int> | default = 75 ] rule_files: [ - <filepath_glob> ... ] scrape_config_files: [ - <filepath_glob> ... ] scrape_configs: [ - <scrape_config> ... ] alerting: alert_relabel_configs: [ - <relabel_config> ... ] alertmanagers: [ - <alertmanager_config> ... ] remote_write: [ - <remote_write> ... ] otlp: [ promote_resource_attributes: [<string> , ... ] | default = [ ] ] [ promote_all_resource_attributes: <boolean> | default = false ] [ ignore_resource_attributes: [<string> , ... ] | default = [] ] [ translation_strategy: <string> | default = "UnderscoreEscapingWithSuffixes" ] [ keep_identifying_resource_attributes: <boolean> | default = false ] [ convert_histograms_to_nhcb: <boolean> | default = false ] [ promote_scope_metadata: <boolean> | default = false ] remote_read: [ - <remote_read> ... ] storage: [ tsdb: <tsdb> ] [ exemplars: <exemplars> ] tracing: [ <tracing_config> ]

scrape_protocols

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 📖 参数含义 scrape_protocols - 抓取协议协商 - 作用: 定义 Prometheus 与目标服务通信时支持的协议格式 - 类型: [<string>, ...] (字符串列表) - 大小写敏感: 必须严格按照示例的大小写 🔄 支持的协议 1. PrometheusProto - 格式: Protocol Buffers 二进制格式 - 特点: 高效、紧凑、性能最好 - 适用: 现代化的指标导出器 2. OpenMetricsText1.0.0 - 格式: OpenMetrics 1.0.0 标准文本格式 - 特点: 标准化、兼容性好 - 适用: 遵循 OpenMetrics 标准的服务 3. OpenMetricsText0.0.1 - 格式: OpenMetrics 0.0.1 旧版文本格式 - 特点: 向后兼容 - 适用: 较老的 OpenMetrics 实现 4. PrometheusText0.0.4 - 格式: Prometheus 经典文本格式 - 特点: 最常用、兼容性最强 - 适用: 大部分现有的 Prometheus exporters 🎯 协议协商机制 Prometheus 会按照列表顺序与目标协商使用哪种协议: scrape_protocols: [ PrometheusProto, OpenMetricsText1.0.0, PrometheusText0.0.4 ] # 协商过程: # 1. Prometheus: "支持 PrometheusProto 吗?" # 2. 如果目标支持 → 使用 PrometheusProto # 3. 如果不支持 → "支持 OpenMetricsText1.0.0 吗?" # 4. 如果目标支持 → 使用 OpenMetricsText1.0.0 # 5. 如果不支持 → 继续尝试下一个... 🔄 默认值变化 默认情况: # 默认协议顺序 [ OpenMetricsText1.0.0, OpenMetricsText0.0.1, PrometheusText0.0.4 ] 启用原生直方图时: # 当 --enable-feature=native-histogram 时 [ PrometheusProto, OpenMetricsText1.0.0, OpenMetricsText0.0.1, PrometheusText0.0.4 ] 注意: 启用原生直方图时,PrometheusProto 会排在第一位,因为它对原生直方图支持最好。 🔧 实际配置示例 1. 默认配置 (你的情况) global: # 没有设置 scrape_protocols,使用默认值 scrape_interval: 15s # 实际效果: # scrape_protocols: [ OpenMetricsText1.0.0, OpenMetricsText0.0.1, PrometheusText0.0.4 ] 2. 优化性能配置 global: scrape_protocols: [ PrometheusProto, OpenMetricsText1.0.0 ] # 优先使用二进制协议,性能更好 3. 兼容性优先配置 global: scrape_protocols: [ PrometheusText0.0.4, OpenMetricsText0.0.1 ] # 确保与老版本 exporters 兼容 4. 启用原生直方图配置 # 命令行启动时 ./prometheus --enable-feature=native-histograms # 配置文件 global: # 会自动使用: # [ PrometheusProto, OpenMetricsText1.0.0, OpenMetricsText0.0.1, PrometheusText0.0.4 ] 📊 协议选择建议 推荐配置 (生产环境): global: scrape_protocols: [ PrometheusProto, OpenMetricsText1.0.0, PrometheusText0.0.4 ] 优势: - 优先使用高效的二进制协议 - 保持向后兼容性 - 覆盖大部分使用场景 保守配置 (兼容性优先): global: scrape_protocols: [ PrometheusText0.0.4, OpenMetricsText0.0.1 ] 适用: 需要与老版本或非标准实现兼容的环境 ⚠️ 注意事项 1. 大小写敏感 # ✅ 正确 scrape_protocols: [ PrometheusProto, OpenMetricsText1.0.0 ] # ❌ 错误 scrape_protocols: [ prometheusproto, OpenMetricstext1.0.0 ] 2. 协议顺序重要 # 不同的顺序会有不同的协商结果 [ PrometheusProto, OpenMetricsText1.0.0 ] # 优先二进制 [ OpenMetricsText1.0.0, PrometheusProto ] # 优先文本 3. 与目标服务匹配 确保你的监控目标支持配置的协议,否则协商可能失败。 你的配置使用默认值是一个安全的选择,适合大多数使用场景。

PrometheusProto, OpenMetricsText1.0.0, OpenMetricsText0.0.1, PrometheusText0.0.4

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 🎯 概览对比表 | 协议 | 类型 | 标准化 | 性能 | 兼容性 | 主要用途 | |----------------------|-----|------------|-----|-----|-------| | PrometheusProto | 二进制 | Prometheus | 最高 | 中等 | 高性能场景 | | OpenMetricsText1.0.0 | 文本 | CNCF 标准 | 中等 | 高 | 标准化监控 | | OpenMetricsText0.0.1 | 文本 | 旧版标准 | 中等 | 高 | 向后兼容 | | PrometheusText0.0.4 | 文本 | Prometheus | 中等 | 最高 | 最广泛兼容 | 🔧 PrometheusProto (Protocol Buffers) 格式特征: // 二进制格式示例(简化) message WriteRequest { repeated TimeSeries timeseries = 1; repeated MetricMetadata metadata = 2; } message TimeSeries { repeated Label labels = 1; repeated Sample samples = 2; } 优势: - ⚡ 性能最佳: 二进制压缩,解析速度快 - 📦 传输高效: 网络传输量更小 - 🔒 类型安全: 强类型定义,减少解析错误 - 🎯 原生直方图: 对原生直方图支持最好 劣势: - 🔍 调试困难: 二进制格式不易人工查看 - 🔧 工具限制: 需要专门工具解析 - 📊 生态支持: 并非所有工具都支持 适用场景: # 高性能环境 scrape_protocols: [ PrometheusProto, OpenMetricsText1.0.0 ] 📝 OpenMetricsText1.0.0 (CNCF 标准) 格式特征: # 标准化的 OpenMetrics 格式 # HELP http_requests_total The total number of HTTP requests. # TYPE http_requests_total counter # UNIT http_requests_total requests http_requests_total{method="GET",code="200"} 1027 # 明确的直方图格式 # TYPE latency_seconds histogram # UNIT latency_seconds seconds latency_seconds_bucket{le="0.1"} 24054 latency_seconds_bucket{le="0.5"} 33444 latency_seconds_bucket{le="+Inf"} 10000 latency_seconds_sum 1.7560473e+07 latency_seconds_count 2633 # EOF 必须存在 优势: - 🎯 官方标准: CNCF 认证标准 - 🔗 跨工具兼容: 多个监控工具支持 - 📋 元数据丰富: 明确的单位、类型定义 - 📊 结构清晰: 人类可读,机器易解析 新增特性: # 单位信息 (UNIT) # UNIT cpu_usage_percent percent # UNIT memory_bytes bytes # 信息指标 (Info) # TYPE node_info info node_info{version="1.0",os="linux"} 1 # 状态集合 (StateSet) # TYPE feature_flags stateset feature_flags{feature="beta"} 1 feature_flags{feature="alpha"} 0 📚 OpenMetricsText0.0.1 (旧版标准) 格式特征: # 与 1.0.0 基本相同,但缺少一些新特性 # HELP http_requests_total The total number of HTTP requests. # TYPE http_requests_total counter http_requests_total{method="GET",code="200"} 1027 # 没有 EOF 标记要求 主要差异: - 📝 元数据较少: 缺少 UNIT 等新字段 - 🔄 向后兼容: 与 Prometheus 格式更接近 - 📊 功能有限: 不支持最新特性 🏛️ PrometheusText0.0.4 (经典格式) 格式特征: # Prometheus 原始格式 # HELP http_requests_total The total number of HTTP requests. # TYPE http_requests_total counter http_requests_total{method="GET",code="200"} 1027 # 直方图格式略有不同 # HELP http_request_duration_seconds A histogram of the request duration. # TYPE http_request_duration_seconds histogram http_request_duration_seconds_bucket{le="0.05"} 24054 http_request_duration_seconds_bucket{le="+Inf"} 10000 http_request_duration_seconds_sum 1.7560473e+07 http_request_duration_seconds_count 2633 特点: - 🔧 最成熟: 经过长期验证的格式 - 🌐 最广泛支持: 几乎所有 Prometheus 兼容工具都支持 - 📊 简单直接: 易于理解和实现 - 🎯 生态标准: Prometheus 生态系统的事实标准 🔄 协议协商过程 scrape_protocols: [ PrometheusProto, OpenMetricsText1.0.0, OpenMetricsText0.0.1, PrometheusText0.0.4 ] 协商流程: Prometheus → Target: "支持 PrometheusProto 吗?" ├─ ✅ 支持 → 使用 PrometheusProto (最快) └─ ❌ 不支持 → "支持 OpenMetricsText1.0.0 吗?" ├─ ✅ 支持 → 使用 OpenMetricsText1.0.0 (标准化) └─ ❌ 不支持 → "支持 OpenMetricsText0.0.1 吗?" ├─ ✅ 支持 → 使用 OpenMetricsText0.0.1 (兼容) └─ ❌ 不支持 → 使用 PrometheusText0.0.4 (最兼容) 📈 性能对比 | 操作 | PrometheusProto | OpenMetricsText1.0.0 | PrometheusText0.0.4 | |--------|-----------------|----------------------|---------------------| | 序列化 | 快 | 中等 | 中等 | | 反序列化 | 快 | 中等 | 中等 | | 网络传输 | 小 | 大 | 大 | | 内存占用 | 低 | 高 | 高 | | CPU 使用 | 低 | 中等 | 中等 | 🎯 选择建议 生产环境推荐配置: # 平衡性能和兼容性 scrape_protocols: [ PrometheusProto, OpenMetricsText1.0.0, PrometheusText0.0.4 ] 兼容性优先配置: # 确保最大兼容性 scrape_protocols: [ OpenMetricsText1.0.0, PrometheusText0.0.4 ] 性能优先配置: # 追求最高性能 scrape_protocols: [ PrometheusProto, OpenMetricsText1.0.0 ] 💡 你的配置分析 你的配置使用默认协议顺序: # 默认情况下 scrape_protocols: [ OpenMetricsText1.0.0, OpenMetricsText0.0.1, PrometheusText0.0.4 ] 这是一个很好的选择: - 🎯 优先使用标准化格式 - 🔄 自动回退到兼容格式 - 🛡️ 确保与各种目标都能通信 - 📊 平衡了标准性和兼容性 如果启用原生直方图功能,会自动调整为: # --enable-feature=native-histograms 时 scrape_protocols: [ PrometheusProto, OpenMetricsText1.0.0, OpenMetricsText0.0.1, PrometheusText0.0.4 ] 这样会优先使用性能更好的二进制协议来处理原生直方图。

evaluation_interval

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 🔍 独立运行的任务 抓取数据 和 评估规则 是两个独立的调度任务,它们各自按照自己的间隔运行,不会互相阻塞。 ✅ 正确的时间线 你的配置: global: scrape_interval: 15s # 抓取调度器 evaluation_interval: 1m # 规则评估调度器 实际运行情况: 时间线: 00:00 - 规则评估 (使用当前已有数据) 00:15 - 抓取数据 00:30 - 抓取数据 00:45 - 抓取数据 01:00 - 规则评估 (使用最新抓取的数据) + 同时可能也在抓取数据 01:15 - 抓取数据 01:30 - 抓取数据 01:45 - 抓取数据 02:00 - 规则评估 + 同时可能也在抓取数据 ⚙️ 并发执行机制 两个独立的调度器: // 伪代码展示并发执行 func main() { // 抓取调度器 - 每15秒运行 go func() { for { scrapeTargets() // 抓取数据 time.Sleep(15s) } }() // 规则评估调度器 - 每1分钟运行 go func() { for { evaluateRules() // 评估规则 time.Sleep(1m) } }() } 01:00 时刻的情况: 在 01:00 这一时刻: ├─ 规则评估调度器触发 │ └─ 评估所有告警规则 │ └─ 使用 TSDB 中最新的数据 │ └─ 抓取调度器可能也同时触发 └─ 抓取目标的指标数据 └─ 将新数据写入 TSDB 🎯 关键点 1. 不会互相等待: - 规则评估不会等待数据抓取完成 - 数据抓取也不会等待规则评估完成 - 两者完全独立运行 2. 数据一致性: # 规则评估时使用的是 TSDB 中已有的数据 # 不一定是最新抓取的数据 expr: cpu_usage > 80 # 在 01:00 评估时,可能使用的是 00:45 抓取的数据 # 01:00 抓取的新数据要等到 02:00 评估时才会用到 3. 时间重叠处理: 01:00 时刻: ├─ 规则评估开始 (使用 00:45 的数据) ├─ 数据抓取开始 (获取新数据) ├─ 规则评估完成 (生成告警状态) └─ 数据抓取完成 (新数据写入TSDB,下次评估使用) 📊 实际影响 最大数据延迟: # 最坏情况下的数据延迟 问题发生时刻: 00:46 下次抓取: 01:00 (但可能稍晚几毫秒) 下次评估: 01:00 (使用00:45的数据,还没看到问题) 再次评估: 02:00 (使用01:00的数据,此时才看到问题) # 实际最大延迟 ≈ 15s (抓取间隔) + 60s (评估间隔) = 75秒 为什么这样设计: - ✅ 性能优化: 避免评估等待抓取 - ✅ 资源隔离: 两个任务互不干扰 - ✅ 简化调度: 各自独立,逻辑清晰 - ✅ 容错性: 一个任务失败不影响另一个

rule_query_offset

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 ⏺ 📖 参数含义 rule_query_offset - 规则查询时间偏移 - 作用: 将规则评估的时间点向后偏移指定时间,确保底层数据已经到达 - 类型: <duration> (持续时间) - 默认值: 0s (无偏移) - 用途: 解决数据延迟问题 🎯 解决的问题 数据延迟场景: 正常情况: 时间: 09:00:00 指标时间: 09:00:00 (实时数据) 评估: 立即使用 ✅ 延迟情况: 时间: 09:00:00 指标时间: 08:59:30 (延迟30秒) 评估: 使用了不完整的数据 ❌ 具体延迟场景: 1. 远程写入场景: # 架构: Exporter → Prometheus → Remote Storage → Prometheus # 数据流向: # 09:00:00 - Exporter 暴露指标 # 09:00:05 - Prometheus 抓取并写入远程存储 # 09:00:15 - 远程存储持久化完成 # 09:00:30 - Prometheus 从远程存储读取 # 09:01:00 - 规则评估 (此时数据已完整) 2. 网络延迟: # 跨数据中心或云环境 # Exporter 在 A 地区 # Prometheus 在 B 地区 # 网络延迟可能导致数据传输慢 3. 抓取异常: # 目标服务偶尔响应慢 # 或网络抖动导致抓取失败重试 # 数据到达时间不规律 ⏰ 工作原理 无偏移 (默认): global: evaluation_interval: 1m rule_query_offset: 0s # 默认值 # 评估时间点: # 09:00:00 - 评估 09:00:00 的数据 # 09:01:00 - 评估 09:01:00 的数据 # 09:02:00 - 评估 09:02:00 的数据 有偏移: global: evaluation_interval: 1m rule_query_offset: 30s # 偏移30秒 # 评估时间点: # 09:00:00 - 评估 08:59:30 的数据 (向前推30秒) # 09:01:00 - 评估 09:00:30 的数据 (向前推30秒) # 09:02:00 - 评估 09:01:30 的数据 (向前推30秒) 🔧 配置示例 1. 远程写入环境: global: evaluation_interval: 1m rule_query_offset: 2m # 给远程写入2分钟缓冲时间 # 确保从远程存储读取时数据已完整 2. 网络不稳定环境: global: evaluation_interval: 30s rule_query_offset: 45s # 45秒偏移应对网络延迟 # 适合跨云或跨地域部署 3. 大规模抓取: global: scrape_interval: 15s evaluation_interval: 1m rule_query_offset: 1m # 1分钟偏移确保所有数据到达 # 当抓取目标很多时,完成一轮需要时间 📊 实际影响分析 延迟计算: # 你的配置 (假设添加了偏移) global: scrape_interval: 15s evaluation_interval: 1m rule_query_offset: 30s # 告警响应时间: # 问题发生 → 最多15秒被抓取 → 最多30秒偏移缓冲 → 1分钟评估 → 5分钟for时间 # 总延迟 ≈ 15s + 30s + 1m + 5m = 6分45秒 数据新鲜度: # 无偏移: 使用最新数据,但可能不完整 rule_query_offset: 0s # 查询时间: 09:00:00 → 数据范围: 09:00:00 ± 5m # 有偏移: 使用稍旧数据,但更可靠 rule_query_offset: 30s # 查询时间: 09:00:00 → 数据范围: 08:59:30 ± 5m 🎯 使用建议 何时需要设置: - ✅ 远程写入架构: Prometheus 作为远程写入目标 - ✅ 跨地域部署: 网络延迟较高 - ✅ 大规模抓取: 大量目标导致抓取时间长 - ✅ 数据延迟敏感: 需要确保数据完整性 何时不需要设置: - ❌ 本地部署: 数据路径短,延迟低 - ❌ 简单架构: 单一 Prometheus 实例 - ❌ 实时要求高: 需要立即响应变化 - ❌ 资源充足: 可以接受偶发的数据不完整 推荐设置: # 根据架构复杂度调整 rule_query_offset: 30s # 轻微延迟 rule_query_offset: 1m # 中等延迟 rule_query_offset: 2m # 较重延迟 💡 与你的配置关系 你的当前配置: global: scrape_interval: 15s evaluation_interval: 1m # rule_query_offset: 0s (默认,无偏移) 这是合理的: - ✅ 本地部署: 假设是本地或同网络环境 - ✅ 数据及时: 无额外延迟,告警响应快 - ✅ 简单架构: 适合大多数标准部署 如果遇到以下情况,可以考虑添加偏移: - 发现告警总是延迟触发 - 确认存在数据传输延迟 - 使用了远程存储或远程写入架构 总的来说,这个参数是一个保险机制,在数据延迟不可控时提供可靠性保障。

external_labels

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 ⏺ 📖 参数含义 external_labels - 外部标签 - 作用: 为所有时间序列和告警添加全局标签,用于与外部系统通信 - 用途: 联邦、远程存储、Alertmanager 通信 - 环境变量: 支持环境变量引用 ${var} 或 $var 🏷️ 标签添加范围 影响的外部系统: 1. Federation (联邦): 其他 Prometheus 实例抓取时 2. Remote Storage (远程存储): 发送到远程存储系统时 3. Alertmanager: 发送告警到 Alertmanager 时 不影响的范围: - ❌ 本地查询和规则评估 - ❌ 本地 API 响应 - ❌ 直接查看的指标 🔧 基础配置示例 你的配置: global: external_labels: monitor: "codelab-monitor" 实际效果: # 原始指标 http_requests_total{instance="localhost:9090", job="prometheus"} 100 # 添加外部标签后 (发送到外部系统时) http_requests_total{instance="localhost:9090", job="prometheus", monitor="codelab-monitor"} 100 🌍 环境变量支持 基本语法: external_labels: # 两种环境变量语法 cluster: "${CLUSTER_NAME}" # 推荐语法 region: "$REGION" # 简化语法 datacenter: "${DATACENTER:-default}" # 默认值语法 version: "v1.2.3-${BUILD_ID}" # 与静态值组合 转义处理: external_labels: # 转义 $ 字符 literal_dollar: "$$escaped_value" # 结果: $escaped_value money_sign: "$${CURRENCY}" # 如果CURRENCY=USD,结果: $USD 环境变量处理规则: - ✅ 存在变量: 替换为实际值 - ❌ 不存在变量: 替换为空字符串 "" - 💡 转义: $$ 转义为单个 $ 🎯 实际应用场景 1. 联邦场景 (Federation): # 主 Prometheus 配置 global: external_labels: prometheus: "main" region: "us-west" cluster: "production" # 子 Prometheus 抓取 # /federate?prometheus=main®ion=us-west&cluster=production 2. 远程存储场景: global: external_labels: source: "prometheus-main" env: "${ENVIRONMENT}" datacenter: "${DATACENTER}" # 所有发送到远程存储的指标都包含这些标签 # 用于区分不同 Prometheus 实例的数据 3. Alertmanager 场景: global: external_labels: cluster: "${CLUSTER_NAME}" region: "${AWS_REGION}" team: "platform" # 告警发送时会自动添加这些标签 # Alertmanager 路由规则可以使用这些标签 🏢 复杂配置示例 生产环境配置: global: external_labels: # 环境信息 environment: "${ENV:-production}" region: "${AWS_REGION:-us-west-2}" availability_zone: "${AZ:-us-west-2a}" # 实例标识 cluster: "${CLUSTER_NAME}" prometheus_instance: "${HOSTNAME}" team: "${TEAM:-platform}" # 版本信息 prometheus_version: "v3.7.3" config_version: "2024.11.09" # 业务标识 business_unit: "infrastructure" cost_center: "IT-OPS" 动态环境变量: # 设置环境变量 export CLUSTER_NAME="prod-k8s-cluster" export AWS_REGION="us-west-2" export TEAM="observability" export DATACENTER="datacenter-1" # Prometheus 启动时会读取这些环境变量 ./prometheus --config.file=prometheus.yml 📊 标签传播机制 告警标签传播: # 规则文件中的告警 - alert: HighCPUUsage expr: cpu_usage > 80 labels: severity: critical annotations: summary: "High CPU usage detected" # 发送到 Alertmanager 时自动添加外部标签: { "labels": { "alertname": "HighCPUUsage", "severity": "critical", "monitor": "codelab-monitor" # ← external_labels 添加 } } 联邦查询标签: # 源 Prometheus global: external_labels: source: "main-prometheus" region: "us-west" # 目标 Prometheus 联邦查询 scrape_configs: - job_name: 'federate' honor_labels: true metrics_path: /federate params: 'match[]': - '{__name__=~".+"}' static_configs: - targets: ['source-prometheus:9090'] # 获取到的指标包含源的外部标签 up{job="federate", instance="source-prometheus:9090", source="main-prometheus", region="us-west"} ⚠️ 注意事项 1. 标签名称规范: # ✅ 正确的标签名 external_labels: cluster: "production" # 符合规范 region: "us-west-2" # 符合规范 # ❌ 错误的标签名 external_labels: app.kubernetes.io/name: "app" # 需要转换为: app_kubernetes_io_name invalid-name: "value" # 包含连字符,需要转换 2. 环境变量处理: # 安全的环境变量引用 external_labels: # 使用默认值避免空值 cluster: "${CLUSTER_NAME:-unknown}" # 确保变量存在或提供默认值 environment: "${ENVIRONMENT:-production}" 3. 标签数量控制: # 避免添加过多标签 external_labels: # ✅ 必要标签 cluster: "prod-cluster" region: "us-west-2" # ❌ 避免添加过多详细信息 # pod_name: "${POD_NAME}" # 变化太频繁 # container_id: "${CONTAINER_ID}" # 无关信息 💡 你的配置分析 你的配置: global: external_labels: monitor: "codelab-monitor" 这是一个很好的实践: - ✅ 标识明确: 清楚标识数据来源 - ✅ 简洁有效: 只添加必要的标识信息 - ✅ 便于管理: 在多 Prometheus 环境中容易区分 - ✅ 告警有用: Alertmanager 可以基于此标签路由 建议可以根据需要逐步扩展,添加更多环境或业务相关的标签。

query_log_file + scrape_failure_log_file

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 ⏺ 📖 日志配置参数解释 1. query_log_file - PromQL 查询日志 含义: - 记录所有执行的 PromQL 查询 - 包括来自 API、Web UI、规则评估的查询 - 配置重载时会重新打开文件 用途: - 🔍 审计查询活动 - 🐛 调试性能问题 - 📊 分析查询模式 - 🛡️ 安全审计 配置示例: global: query_log_file: "/var/log/prometheus/queries.log" 日志格式: 2024-11-09T10:15:30.123Z http://localhost:9090/api/v1/query?query=up&time=1731135330.123 2024-11-09T10:15:35.456Z http://localhost:9090/api/v1/query_range?query=rate(http_requests_total[5m])&start=1731 135300&end=1731135330&step=15 2024-11-09T10:16:00.789Z rule=HighCPUUsage query=cpu_usage > 80 2. scrape_failure_log_file - 抓取失败日志 含义: - 记录所有抓取失败的详细信息 - 包括超时、连接错误、HTTP错误等 - 配置重载时会重新打开文件 用途: - 🔧 监控抓取问题 - 🐛 排查目标服务问题 - 📊 统计失败率 - 🚨 及时发现服务异常 配置示例: global: scrape_failure_log_file: "/var/log/prometheus/scrape_failures.log" 日志格式: 2024-11-09T10:15:30.123Z scrape_failed job="node" instance="localhost:9100" error="context deadline exceeded" 2024-11-09T10:15:45.456Z scrape_failed job="api" instance="api.example.com:8080" error="connection refused" 2024-11-09T10:16:00.789Z scrape_failed job="web" instance="web.example.com:80" error="HTTP 500 Internal Server Error" 🎯 实际应用场景 查询日志 (query_log_file) 1. 性能调试: # 发现慢查询 grep "rate(http_requests_total[1h])" /var/log/prometheus/queries.log # 分析查询频率 cat /var/log/prometheus/queries.log | awk '{print $1}' | sort | uniq -c 2. 安全审计: # 查看谁在查询敏感指标 grep "secrets" /var/log/prometheus/queries.log # 分析查询模式 grep "http://.*:3000" /var/log/prometheus/queries.log # Grafana 查询 3. 调试规则: # 查看规则评估查询 grep "rule=" /var/log/prometheus/queries.log 抓取失败日志 (scrape_failure_log_file) 1. 监控目标健康: # 统计失败目标 cat /var/log/prometheus/scrape_failures.log | grep -o 'instance="[^"]*"' | sort | uniq -c # 分析失败类型 cat /var/log/prometheus/scrape_failures.log | grep -o 'error="[^"]*"' | sort | uniq -c 2. 网络问题排查: # 查看网络相关错误 grep -E "(timeout|refused|connection)" /var/log/prometheus/scrape_failures.log 3. 配置验证: # 检查哪些 job 经常失败 grep -o 'job="[^"]*"' /var/log/prometheus/scrape_failures.log | sort | uniq -c | sort -nr ⚙️ 配置建议 生产环境配置: global: # 启用查询日志用于审计 query_log_file: "/var/log/prometheus/queries.log" # 启用抓取失败日志用于监控 scrape_failure_log_file: "/var/log/prometheus/scrape_failures.log" 开发环境配置: global: # 开发环境可以启用详细日志 query_log_file: "/tmp/prometheus-queries.log" scrape_failure_log_file: "/tmp/prometheus-scrape-failures.log" 调试时临时启用: global: # 临时开启用于调试 query_log_file: "/var/log/prometheus/debug-queries.log" 🔧 文件管理 日志轮转 (logrotate 配置): # /etc/logrotate.d/prometheus-logs /var/log/prometheus/*.log { daily rotate 7 compress delaycompress missingok notifempty create 644 prometheus prometheus postrotate kill -USR1 $(cat /var/run/prometheus.pid) endscript } 监控日志大小: # 监控日志文件大小 du -sh /var/log/prometheus/*.log # 实时监控日志 tail -f /var/log/prometheus/scrape_failures.log ⚠️ 注意事项 性能影响: - ✅ 查询日志: 轻微性能开销 - ⚠️ 抓取失败日志: 失败较多时可能影响性能 - 💾 磁盘空间: 需要监控日志文件大小 敏感信息: - 🔒 查询日志: 可能包含敏感的查询信息 - 🛡️ 访问控制: 限制日志文件的访问权限 文件权限: # 设置合适的文件权限 chown prometheus:prometheus /var/log/prometheus/*.log chmod 640 /var/log/prometheus/*.log 💡 最佳实践 1. 渐进式启用: # 先启用抓取失败日志 scrape_failure_log_file: "/var/log/prometheus/scrape_failures.log" # 后续根据需要启用查询日志 query_log_file: "/var/log/prometheus/queries.log" 2. 定期分析: # 设置定期分析脚本 # 每天分析失败率,每周分析查询模式 3. 与监控集成: # 在日志中提取指标用于监控 # 例如: prometheus_scrape_failures_total{job="node"} 这两个日志功能是 Prometheus 运维的重要工具,建议在生产环境中启用抓取失败日志,根据需要启用查询日志。

body_size_limit + sample_limit + label_limit + label_name_length_limit + label_value_length_limit + target_limit

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 这些参数用于控制 Prometheus 抓取过程中的资源使用和稳定性保护。 🎯 1. body_size_limit - 响应体大小限制 含义: - 限制目标服务返回的未压缩响应体大小 - 超过限制时整个抓取失败 - 0 表示无限制 配置示例: global: body_size_limit: 100MB # 限制100MB # 或者 body_size_limit: 50MB # 限制50MB body_size_limit: 0 # 无限制 (默认) 适用场景: - ✅ 防止目标服务返回过多数据 - ✅ 避免内存溢出 - ✅ 保护 Prometheus 稳定性 - ⚠️ 实验性功能,可能变化 🔢 2. sample_limit - 样本数量限制 含义: - 限制每次抓取接受的样本数量 - 在指标重标签后计算 - 超过限制时整个抓取失败 配置示例: global: sample_limit: 1000000 # 限制100万个样本 # 或者针对特定job scrape_configs: - job_name: "heavy_metrics" sample_limit: 500000 # 该job限制50万样本 实际影响: # 正常情况: 10,000 个样本 ✅ # 超过限制: 1,500,000 个样本 ❌ (如果 limit=1,000,000) 🏷️ 3. label_limit - 标签数量限制 含义: - 限制每个样本的标签数量 - 在指标重标签后检查 - 任何样本超过限制都导致整个抓取失败 配置示例: global: label_limit: 50 # 每个样本最多50个标签 scrape_configs: - job_name: "labeled_metrics" label_limit: 30 # 该job每个样本最多30个标签 标签示例: # 正常样本: ~10-20个标签 ✅ metric{job="api",instance="1.2.3.4",method="GET",status="200",...} 100 # 标签过多: 可能100+个标签 ❌ metric{label1="value1",label2="value2",...,label100="value100"} 100 📏 4. label_name_length_limit - 标签名长度限制 含义: - 限制每个标签名的字节长度 - UTF-8编码,字符可能占1-4字节 - 任何标签名超长都导致抓取失败 配置示例: global: label_name_length_limit: 512 # 标签名最多512字节 # 或者更严格 label_name_length_limit: 256 # 标签名最多256字节 UTF-8 字符计算: # ASCII字符: 1字节 "job" = 3字节 ✅ # 中文字符: 3字节 "中文标签" = 12字节 ✅ # Emoji: 4字节 "🏷️label" = 8字节 ✅ 📝 5. label_value_length_limit - 标签值长度限制 含义: - 限制每个标签值的字节长度 - UTF-8编码,字符可能占1-4字节 - 任何标签值超长都导致抓取失败 配置示例: global: label_value_length_limit: 2048 # 标签值最多2048字节 # 或者针对不同job scrape_configs: - job_name: "api_metrics" label_value_length_limit: 1024 实际示例: # 正常值 version: "1.2.3" # 7字节 ✅ build_id: "abc123" # 6字节 ✅ # 可能过长的值 trace_id: "550e8400-e29b-41d4-a716-446655440000" # 36字节 ✅ long_description: "这是一个很长的描述文本..." # 可能超长 ❌ 🎯 6. target_limit - 目标数量限制 含义: - 限制每个抓取配置的唯一目标数量 - 在目标重标签后计算 - 超过限制时目标被标记为失败,不进行抓取 - 实验性功能 配置示例: global: target_limit: 10000 # 全局限制1万个目标 scrape_configs: - job_name: "kubernetes_pods" target_limit: 5000 # 该job限制5000个目标 实际效果: # Kubernetes服务发现可能返回数千个pod # 限制后只抓取前5000个,其余标记为失败 🔧 综合配置示例 生产环境配置: global: # 响应体大小限制 body_size_limit: 100MB # 样本数量限制 sample_limit: 5000000 # 标签相关限制 label_limit: 100 label_name_length_limit: 512 label_value_length_limit: 4096 # 目标数量限制 target_limit: 10000 资源受限环境: global: # 更严格的限制 body_size_limit: 50MB sample_limit: 1000000 label_limit: 50 label_name_length_limit: 256 label_value_length_limit: 1024 target_limit: 5000 Job级别配置: scrape_configs: - job_name: "light_metrics" # 轻量级服务,较少限制 sample_limit: 10000 label_limit: 20 - job_name: "heavy_metrics" # 重型服务,严格限制 body_size_limit: 200MB sample_limit: 100000 label_limit: 30 📊 监控这些限制 Prometheus 指标: # 检查抓取失败 prometheus_scrape_samples_scraped_total prometheus_scrape_samples_failed_total # 检查目标状态 up{job="heavy_metrics"} # 0表示抓取失败 日志监控: # 查看抓取失败日志 grep "scrape_failed" /var/log/prometheus/scrape_failures.log | grep "limit" ⚠️ 注意事项 1. 实验性功能: - ⚠️ body_size_limit 和 target_limit 是实验性的 - 🔄 未来版本可能变化 - 📋 生产环境谨慎使用 2. 性能权衡: - ✅ 限制严格: 保护资源,稳定运行 - ❌ 限制过严: 可能丢失重要数据 - ⚖️ 需要根据实际情况调整 3. 配置优先级: # Job级别配置覆盖全局配置 global: sample_limit: 1000000 scrape_configs: - job_name: "special_job" sample_limit: 500000 # 覆盖全局设置 4. 渐进式调整: # 建议从宽松限制开始,根据实际使用情况逐步收紧 sample_limit: 0 # 先无限制运行 sample_limit: 10000000 # 然后设置较宽松限制 sample_limit: 5000000 # 最后调整到合适值 这些限制是保护 Prometheus 稳定运行的重要机制,建议根据实际环境和监控需求合理配置。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 📊 Prometheus Global 限制参数表 | 参数 | 默认值 | 限制对象 | 计算时机 | 超限后果 | 实验性 | 配置格式 | |--------------------------|-----|-----------|--------------------|-------|-----|--------| | body_size_limit | 0 | HTTP响应体大小 | 接收响应时 | 抓取失败 | ✅ | 100MB | | target_limit | 0 | 抓取目标数量 | target_relabeling后 | 目标不抓取 | ✅ | 10000 | | sample_limit | 0 | 样本数量 | metric_relabeling后 | 抓取失败 | ❌ | 500000 | | label_limit | 0 | 每个样本的标签数 | metric_relabeling后 | 抓取失败 | ❌ | 100 | | label_name_length_limit | 0 | 标签名长度 | metric_relabeling后 | 抓取失败 | ❌ | 512 | | label_value_length_limit | 0 | 标签值长度 | metric_relabeling后 | 抓取失败 | ❌ | 2048 | 🎯 快速配置参考 生产环境推荐: global: body_size_limit: 100MB target_limit: 10000 sample_limit: 5000000 label_limit: 100 label_name_length_limit: 512 label_value_length_limit: 2048 资源受限环境: global: body_size_limit: 50MB target_limit: 5000 sample_limit: 1000000 label_limit: 50 label_name_length_limit: 256 label_value_length_limit: 1024 💡 关键要点 - 0 = 无限制 - 所有参数默认无限制 - 字节计算 - UTF-8编码,中文字符占3字节 - 实验性 - body_size_limit 和 target_limit 可能变化 - 渐进调整 - 建议从宽松到严格逐步收紧

keep_dropped_targets

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 227 228 229 230 keep_dropped_targets - 保留丢弃目标的内存限制 - 作用: 限制被 relabeling 丢弃但仍在内存中保留的目标数量 - 类型: <int> (整数) - 默认值: 0 (无限制) - 适用: 每个 scrape 配置 🎯 工作原理 Relabeling 过程: scrape_configs: - job_name: "kubernetes-pods" kubernetes_sd_configs: - role: pod relabel_configs: # 丢弃某些目标 - source_labels: [__meta_kubernetes_pod_annotation_prometheus_io_scrape] regex: "true" action: keep # 只保留有该注解的pod 内存保留机制: 原始发现: 1000个pod targets Relabeling后: 200个有效targets (保留) 丢弃的: 800个targets keep_dropped_targets 控制这800个丢弃目标在内存中的保留数量 💾 内存管理 无限制 (默认): global: keep_dropped_targets: 0 # 默认值,无限制 # 所有被丢弃的目标都保留在内存中 # 优点: relabeling规则变更时目标能快速恢复 # 缺点: 内存占用可能很高 有限制: scrape_configs: - job_name: "kubernetes-pods" keep_dropped_targets: 1000 # 最多保留1000个丢弃目标 # 超过限制的丢弃目标会从内存中清理 # 优点: 节省内存 # 缺点: 目标恢复需要重新发现 🔧 实际应用场景 1. Kubernetes 环境: scrape_configs: - job_name: "kubernetes-pods" kubernetes_sd_configs: - role: pod relabel_configs: # 只监控带有特定注解的pod - source_labels: [__meta_kubernetes_pod_annotation_prometheus_io_scrape] regex: "true" action: keep keep_dropped_targets: 5000 # 保留5000个被丢弃的pod信息 # 场景: 集群中有大量pod,只有少数需要监控 # 保留被丢弃的pod信息,当注解变更时能快速恢复监控 2. 大规模服务发现: scrape_configs: - job_name: "consul-services" consul_sd_configs: - server: consul:8500 relabel_configs: # 过滤不需要监控的服务 - source_labels: [__meta_consul_tags] regex: ".*,monitoring,.*" action: keep keep_dropped_targets: 2000 # 场景: Consul中有几千个服务,只有带monitoring标签的才监控 3. 动态环境: scrape_configs: - job_name: "dynamic-targets" file_sd_configs: - files: ["/etc/prometheus/targets/*.yml"] relabel_configs: # 根据环境变量过滤 - source_labels: [__meta_filesd_env] regex: "${ENVIRONMENT}" action: keep keep_dropped_targets: 1000 # 场景: 目标经常变更,需要保留历史信息 📊 内存使用对比 配置示例: # 场景: 发现10000个目标,relabeling后保留1000个 # 被丢弃: 9000个目标 # 配置1: 无限制 (默认) keep_dropped_targets: 0 # 内存占用: ~9000个目标的元数据 # 配置2: 有限制 keep_dropped_targets: 1000 # 内存占用: ~1000个目标的元数据 (节省90%内存) 内存估算: # 每个丢弃目标的内存开销 # 标签信息: ~200-500字节 # 元数据: ~100-300字节 # 总计: ~300-800字节/目标 # 10000个丢弃目标 ≈ 3-8MB 内存 # 1000个丢弃目标 ≈ 0.3-0.8MB 内存 ⚙️ 配置建议 根据环境选择: 🏭 生产环境: scrape_configs: - job_name: "production-pods" keep_dropped_targets: 5000 # 平衡内存和恢复速度 💾 资源受限环境: scrape_configs: - job_name: "edge-devices" keep_dropped_targets: 500 # 严格限制内存使用 🔬 开发环境: scrape_configs: - job_name: "dev-services" keep_dropped_targets: 0 # 开发环境无限制 根据目标类型选择: 稳定目标: # 目标很少变更,可以设置较低限制 keep_dropped_targets: 100 动态目标: # 目标频繁变更,设置较高限制便于快速恢复 keep_dropped_targets: 5000 🔍 监控和调试 监控内存使用: # 查看 Prometheus 内存使用 curl http://localhost:9090/api/v1/series?match[]=process_resident_memory_bytes # 查看目标数量 curl http://localhost:9090/api/v1/series?match[]=prometheus_sd_discovered_targets 调整建议: # 1. 先运行观察内存使用 keep_dropped_targets: 0 # 2. 根据实际使用情况设置限制 keep_dropped_targets: 2000 # 3. 监控内存变化,继续调整 ⚠️ 注意事项 1. 性能影响: - ✅ 限制较多: 节省内存,但目标恢复慢 - ❌ 无限制: 内存占用高,但目标恢复快 - ⚖️ 需要根据实际情况权衡 2. 配置层级: # 这个参数通常在 scrape_config 级别设置 scrape_configs: - job_name: "example" keep_dropped_targets: 1000 # 在这里设置 # 而不是在 global 级别 global: # keep_dropped_targets: 1000 # ❌ 这样设置无效 3. 与其他限制配合: scrape_configs: - job_name: "kubernetes-pods" # 综合配置 target_limit: 5000 # 限制总目标数 sample_limit: 1000000 # 限制样本数 keep_dropped_targets: 2000 # 限制丢弃目标内存 💡 最佳实践 1. 渐进式调整: # 步骤1: 无限制运行观察 keep_dropped_targets: 0 # 步骤2: 根据内存使用设置限制 keep_dropped_targets: 5000 # 步骤3: 继续优化到合适值 keep_dropped_targets: 2000 2. 分级配置: # 根据job重要性分级 scrape_configs: - job_name: "critical-services" keep_dropped_targets: 5000 # 重要服务,保留更多 - job_name: "debug-metrics" keep_dropped_targets: 100 # 调试指标,严格限制 这个参数主要用于大规模服务发现环境中控制内存使用,特别是在 Kubernetes 或 Consul 等环境中,当发现的目标数量远大于实际监控的目标数量时非常有用。

metric_name_validation_scheme

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 ⏺ 📖 参数含义 metric_name_validation_scheme - 指标名称验证方案 - 作用: 定义指标和标签名称的字符验证规则 - 默认值: "utf8" - 选项: "" (空白)、"utf8"、"legacy" 🎯 三种验证方案对比 | 验证方案 | 默认值 | 支持字符 | Unicode支持 | 向后兼容 | 适用场景 | |----------|-----|--------------|-----------|--------|-------| | "utf8" | ✅ | 所有UTF-8字符 | ✅ 完全支持 | ❌ 新标准 | 现代化环境 | | "legacy" | ❌ | 字母、数字、冒号、下划线 | ❌ 仅ASCII | ✅ 兼容旧版 | 保守环境 | | "" (空白) | ❌ | 同"utf8" | ✅ 完全支持 | ❌ 新标准 | 同utf8 | 🔤 字符支持详解 UTF-8 方案 ("utf8"): # ✅ 支持所有这些指标名 cpu_usage_核心 # 中文 + 下划线 métrique_française # 法语字符 метрика_русская # 俄语字符 メトリックス日本語 # 日语字符 📊_system_metrics # Emoji字符 namespace/service:metric # 斜杠、冒号组合 Legacy 方案 ("legacy"): # ✅ 只支持这些 cpu_usage_total # 字母 + 下划线 http_requests_total # 字母 + 下划线 node_memory_available # 字母 + 下划线 prometheus_sd_discovered # 字母 + 下划线 duration:seconds_bucket # 字母 + 冒号 + 下划线 # ❌ 不支持 cpu_usage_核心 # 中文字符 métrique_française # 非ASCII字符 namespace/metric # 斜杠 📊_system_metrics # Emoji 🔧 配置示例 现代环境 (推荐): global: metric_name_validation_scheme: "utf8" # 允许丰富的指标命名 # 支持国际化、特殊符号等 兼容环境: global: metric_name_validation_scheme: "legacy" # 严格的字符限制 # 确保与旧版本兼容 默认行为: global: # 不设置,使用默认值 # 等同于: metric_name_validation_scheme: "utf8" 🌍 国际化支持示例 中文指标名: # UTF-8 模式下 # 指标导出 服务器_cpu使用率{instance="host1"} 75.5 数据库连接池大小{instance="db1"} 10 # 查询 rate(服务器_cpu使用率[5m]) 多语言混合: # 混合语言的指标 api_request_total # 英文 métrique_latence_ms # 法语 応答時間ミリ秒 # 日语 продолжительность_запроса # 俄语 特殊字符: # 支持各种特殊字符 http://server:8080/metrics_rate # URL风格 service:instance:cpu_usage # 层次结构 🚀_system_startup_time_seconds # Emoji ⚠️ 兼容性考虑 PromQL 查询兼容性: # UTF-8 指标在 PromQL 中的使用 # ✅ 正确 rate(服务器_cpu使用率[5m]) # 可能需要转义的特殊字符 rate(http://server:8080/metrics_rate[5m]) # 或者使用标签过滤 rate(metrics_rate{url="http://server:8080"}[5m]) 系统集成影响: # 影响的组件: # 1. Prometheus Server (存储和查询) # 2. Alertmanager (告警规则) # 3. Grafana (可视化) # 4. Remote Storage (远程存储) # 5. Federated Prometheus (联邦) 🔄 迁移指南 从 Legacy 迁移到 UTF-8: # 步骤1: 检查现有指标 # 运行 Prometheus 查看是否有不合规的指标 # 步骤2: 评估影响 # 检查下游系统是否支持 UTF-8 指标名 # 步骤3: 逐步迁移 global: metric_name_validation_scheme: "utf8" # 步骤4: 更新查询和仪表板 # 使用新的 UTF-8 指标名 从 UTF-8 回退到 Legacy: # 如果遇到兼容性问题 global: metric_name_validation_scheme: "legacy" # 需要修改指标导出器 # 使用 ASCII 字符重命名指标 📊 实际应用场景 1. 国际化团队: global: metric_name_validation_scheme: "utf8" # 团队可以使用母语命名指标 # 便于理解和维护 2. 微服务架构: global: metric_name_validation_scheme: "utf8" # 使用层次化的指标命名 service:user:api:request_total service:payment:db:connection_pool service:notification:email:queue_size 3. 云原生环境: global: metric_name_validation_scheme: "utf8" # 支持 Kubernetes 风格的标签 app.kubernetes.io/name: "myapp" app.kubernetes.io/version: "v1.2.3" 🎯 选择建议 选择 UTF-8 当: - ✅ 团队国际化,需要多语言支持 - ✅ 现代化监控系统 - ✅ 需要丰富的指标命名 - ✅ 下游系统支持 UTF-8 选择 Legacy 当: - ✅ 需要与旧版本 Prometheus 兼容 - ✅ 下游系统不支持 UTF-8 - ✅ 保守的生产环境 - ✅ 只需要基础的 ASCII 字符 💡 你的配置分析 你的配置使用默认值: global: # metric_name_validation_scheme: "utf8" (默认) 这是很好的选择: - ✅ 现代化: 支持完整的 UTF-8 字符集 - ✅ 国际化: 支持多语言指标命名 - ✅ 灵活性: 允许丰富的命名约定 - ✅ 未来兼容: 符合云原生监控的发展趋势 如果将来遇到兼容性问题,可以随时切换到 legacy 模式。

convert_classic_histograms_to_nhcb + always_scrape_classic_histograms

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 ⏺ 📊 Prometheus 直方图配置参数详解 这两个参数都与 Prometheus 的原生直方图功能相关。 🎯 1. convert_classic_histograms_to_nhcb - 经典直方图转换 含义: - 将所有抓取的经典直方图转换为原生直方图 - NHCB = Native Histograms with Custom Buckets - 需要启用原生直方图功能: --enable-feature=native-histograms 配置示例: global: convert_classic_histograms_to_nhcb: true # 启用转换 # convert_classic_histograms_to_nhcb: false # 默认值,不转换 转换效果: # 经典直方图 (抓取前) http_request_duration_seconds_bucket{le="0.1"} 100 http_request_duration_seconds_bucket{le="0.5"} 300 http_request_duration_seconds_bucket{le="1.0"} 450 http_request_duration_seconds_bucket{le="+Inf"} 500 http_request_duration_seconds_sum 123.45 http_request_duration_seconds_count 500 # 转换为原生直方图 (存储后) http_request_duration_seconds{n="500",s="123.45",b="0.1,0.5,1.0"} 500 # 其中 b 是自定义桶边界 🔄 2. always_scrape_classic_histograms - 经典直方图抓取控制 含义: - 控制是否同时抓取经典直方图和原生直方图 - 只有启用原生直方图功能时才有效 - 默认情况下,如果原生直方图可用,就不会抓取经典版本 配置示例: global: always_scrape_classic_histograms: true # 同时抓取两种格式 # always_scrape_classic_histograms: false # 默认值 🔧 配置组合效果 场景1: 默认配置 global: # 默认值 convert_classic_histograms_to_nhcb: false always_scrape_classic_histograms: false # 启动命令 ./prometheus --enable-feature=native-histograms # 行为: # - 优先抓取原生直方图 # - 如果没有原生直方图,抓取经典直方图 # - 不进行转换 场景2: 启用转换 global: convert_classic_histograms_to_nhcb: true always_scrape_classic_histograms: false # 启动命令 ./prometheus --enable-feature=native-histograms # 行为: # - 抓取经典直方图 # - 自动转换为原生直方图存储 # - 不保留原始经典格式 场景3: 同时抓取两种格式 global: convert_classic_histograms_to_nhcb: false always_scrape_classic_histograms: true # 启动命令 ./prometheus --enable-feature=native-histograms # 行为: # - 同时抓取原生直方图和经典直方图 # - 两种格式都存储 # - 占用更多存储空间 场景4: 完整兼容模式 global: convert_classic_histograms_to_nhcb: true always_scrape_classic_histograms: true # 启动命令 ./prometheus --enable-feature=native-histograms # 行为: # - 同时抓取两种格式 # - 经典格式转换为原生格式存储 # - 最大兼容性,但存储开销最大 📊 直方图格式对比 | 特性 | 经典直方图 | 原生直方图 | |------|--------|--------| | 存储格式 | 多个时间序列 | 单一时间序列 | | 桶边界 | 预定义 | 动态自适应 | | 精度 | 受限于桶数量 | 更高精度 | | 存储效率 | 较低 | 更高 | | 查询性能 | 一般 | 更好 | | 兼容性 | 广泛支持 | 较新功能 | 🎯 实际应用场景 1. 渐进式迁移: # 步骤1: 启用原生直方图,保持经典兼容 global: convert_classic_histograms_to_nhcb: true always_scrape_classic_histograms: false # 步骤2: 逐步迁移到原生直方图 # 更新 exporters 支持原生直方图 # 步骤3: 完全使用原生直方图 global: convert_classic_histograms_to_nhcb: false always_scrape_classic_histograms: false 2. 高精度监控: global: convert_classic_histograms_to_nhcb: true # 将现有的经典直方图转换为高精度的原生直方图 # 适用于需要精确延迟分析的场景 3. 兼容性优先: global: always_scrape_classic_histograms: true # 确保下游工具能继续使用经典格式 # 适用于 Grafana 仪表板和告警规则依赖经典格式的情况 ⚠️ 重要注意事项 功能启用: # 必须启用原生直方图功能 ./prometheus --enable-feature=native-histograms # 否则这些配置无效 存储影响: # 存储空间需求 # 经典直方图: 基准 # 原生直方图: 通常更节省空间 # 两种格式: 约双倍空间 查询兼容性: # 查询语句可能需要调整 # 经典: histogram_quantile(0.95, rate(http_request_duration_seconds_bucket[5m])) # 原生: histogram_quantile(0.95, rate(http_request_duration_seconds[5m])) 💡 配置建议 对于你的环境: 如果刚开始使用原生直方图: global: convert_classic_histograms_to_nhcb: true always_scrape_classic_histograms: false # 启用转换,享受原生直方图的好处 如果需要最大兼容性: global: convert_classic_histograms_to_nhcb: false always_scrape_classic_histograms: true # 同时支持两种格式,确保兼容性 如果追求最佳性能: global: convert_classic_histograms_to_nhcb: false always_scrape_classic_histograms: false # 完全使用原生直方图,获得最佳性能 🚀 启用示例 # 1. 启动 Prometheus 时启用原生直方图 ./prometheus \ --config.file=prometheus.yml \ --enable-feature=native-histograms \ --storage.tsdb.path=data/ # 2. 配置文件中设置转换策略 global: convert_classic_histograms_to_nhcb: true always_scrape_classic_histograms: false 这些参数主要用于从经典直方图向原生直方图迁移的过渡期,帮助用户平滑升级到新的直方图格式。

gogc

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 gogc - Go 垃圾回收器参数 - 作用: 配置 Go 运行时的垃圾回收器 GOGC 参数 - 默认值: 75 - 类型: <int> (整数) - 影响: 内存使用与 CPU 使用的平衡 🎯 工作原理 GOGC 参数含义: GOGC=75 表示:当新分配的内存达到上次回收后存活内存的 75% 时触发垃圾回收 计算公式: // 触发条件 新分配内存 >= (上次GC后存活内存 * GOGC / 100) // 示例计算 上次GC后存活内存 = 100MB GOGC = 75 触发阈值 = 100MB * 75 / 100 = 75MB // 当新分配75MB内存时,触发下一次GC 📊 不同设置的影响 默认值 (75): runtime: gogc: 75 # 默认值 # 特点: # - 平衡的内存和CPU使用 # - 适合大多数工作负载 # - Go 语言的推荐默认值 较低值 (更频繁GC): runtime: gogc: 50 # 更频繁回收 # 影响: # ✅ 内存占用更低 # ✅ 内存压力更小 # ❌ CPU 使用更高 # ❌ GC 暂停更频繁 较高值 (较少GC): runtime: gogc: 100 # 较少回收 # 影响: # ✅ CPU 使用更低 # ✅ GC 暂停更少 # ❌ 内存占用更高 # ❌ 可能出现内存峰值 🔧 实际配置示例 1. 内存敏感环境: runtime: gogc: 50 # 更积极的GC,减少内存使用 # 适用场景: # - 容器环境内存限制严格 # - 内存成本较高的环境 # - 需要稳定内存占用的应用 2. CPU敏感环境: runtime: gogc: 100 # 减少GC频率,节省CPU # 适用场景: # - CPU资源受限 # - 需要低延迟的处理 # - 内存充足的环境 3. 高负载监控: runtime: gogc: 25 # 非常积极的GC # 适用场景: # - 大量指标处理 # - 需要严格控制内存 # - 可以接受更高CPU使用 4. 稳定性优先: runtime: gogc: 200 # 非常保守的GC # 适用场景: # - 追求最低延迟 # - 内存资源充足 # - 对GC暂停敏感 📈 性能对比表 | GOGC 值 | 内存使用 | CPU 使用 | GC 频率 | 延迟 | 适用场景 | |--------|------|--------|-------|-----|--------| | 25 | 很低 | 很高 | 很高 | 较低 | 内存受限 | | 50 | 低 | 高 | 高 | 低 | 平衡偏内存 | | 75 | 中等 | 中等 | 中等 | 中等 | 默认推荐 | | 100 | 高 | 低 | 低 | 高 | 平衡偏CPU | | 200 | 很高 | 很低 | 很低 | 很高 | CPU受限 | 🎯 Prometheus 特定考虑 工作负载特征: # Prometheus 的内存使用模式: # 1. 大量时间序列数据 # 2. 频繁的数据写入 # 3. 查询时的临时内存分配 # 4. 规则评估的内存需求 推荐配置: # 根据部署规模调整 # 小规模 ( < 100万时间序列) runtime: gogc: 75 # 默认值即可 # 中规模 (100万-1000万时间序列) runtime: gogc: 50 # 稍微积极一些 # 大规模 ( > 1000万时间序列) runtime: gogc: 25 # 更积极的GC控制 🔍 监控和调优 监控 GC 指标: # 查看 Prometheus 自身的 GC 指标 curl http://localhost:9090/metrics | grep gc # 相关指标: # go_gc_duration_seconds - GC 耗时 # go_memstats_heap_alloc_bytes - 堆内存分配 # go_memstats_next_gc_bytes - 下次GC触发阈值 调优流程: # 步骤1: 监控当前GC行为 # 观察 go_gc_duration_seconds 和内存使用模式 # 步骤2: 设置初始值 runtime: gogc: 50 # 步骤3: 监控效果 # 观察CPU和内存使用变化 # 步骤4: 根据结果调整 # 根据实际需求微调 gogc 值 ⚠️ 注意事项 1. 平衡权衡: # 没有完美的值,需要权衡: # - 内存使用 vs CPU 使用 # - GC频率 vs 暂停时间 # - 稳定性 vs 性能 2. 环境差异: # 不同环境可能需要不同设置 # - 物理机 vs 容器 # - 内存充足 vs 内存受限 # - 高负载 vs 低负载 3. 监控影响: # 调整后需要监控: # - 内存使用模式 # - CPU 使用率 # - GC 暂停时间 # - 查询性能 💡 配置建议 生产环境: runtime: gogc: 50 # 稍微保守一些,控制内存使用 开发环境: runtime: gogc: 100 # 可以更宽松,减少GC干扰 容器环境: runtime: gogc: 25 # 容器内存限制通常较严格 资源充足环境: runtime: gogc: 100 # 内存充足时优先考虑性能 🎯 实际应用 你的配置使用默认值: # runtime 部分通常不显式配置 # 使用默认的 gogc: 75 这是一个合理的默认设置: - ✅ 平衡性好: 适合大多数场景 - ✅ 稳定可靠: Go 官方推荐的默认值 - ✅ 易于维护: 不需要特殊调优 如果遇到内存压力或性能问题,可以考虑调整这个参数。通常建议先从 50 开始尝试,然后根据实际效果进一步调整。

rule_files

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 227 228 229 230 231 232 233 234 235 236 237 238 239 240 241 242 243 244 245 246 247 248 249 250 251 252 253 254 255 256 257 258 259 260 261 262 263 264 265 266 267 268 269 270 271 272 273 274 275 276 rule_files - 规则文件配置 - 作用: 指定包含告警规则和录制规则的文件路径 - 格式: 文件路径列表,支持 glob 模式匹配 - 内容: 从所有匹配的文件中读取规则和告警 🔧 基础配置 简单配置: rule_files: - "prometheus.rules.yml" - "alerts.yml" 你的配置: rule_files: - "prometheus.rules.yml" Glob 模式匹配: rule_files: - "rules/*.yml" # rules目录下所有.yml文件 - "alerts/**/*.yaml" # alerts目录及子目录下所有.yaml文件 - "/etc/prometheus/rules.d/*.rules" # 系统配置目录 📋 规则文件内容 录制规则 (Recording Rules): # prometheus.rules.yml groups: - name: recording_rules interval: 30s # 评估间隔,可选 rules: - record: job:http_requests:rate5m expr: rate(http_requests_total[5m]) - record: job:http_requests:rate5m:sum expr: sum(rate(http_requests_total[5m])) 告警规则 (Alerting Rules): # prometheus.rules.yml groups: - name: alert_rules rules: - alert: HighCPUUsage expr: cpu_usage > 80 for: 5m labels: severity: warning annotations: summary: "CPU usage is above 80%" description: "CPU usage has been above 80% for more than 5 minutes" 🎯 完整规则文件示例 综合规则文件: # prometheus.rules.yml groups: # 录制规则组 - name: performance_metrics interval: 15s rules: - record: instance:cpu_usage:rate5m expr: 100 - (avg by(instance) (rate(node_cpu_seconds_total{mode="idle"}[5m])) * 100) - record: instance:memory_usage:rate5m expr: (1 - (node_memory_MemAvailable_bytes / node_memory_MemTotal_bytes)) * 100 # 告警规则组 - name: system_alerts rules: - alert: InstanceDown expr: up == 0 for: 1m labels: severity: critical annotations: summary: "Instance {{ $labels.instance }} is down" description: "Instance {{ $labels.instance }} has been down for more than 1 minute" - alert: HighCPUUsage expr: instance:cpu_usage:rate5m > 80 for: 5m labels: severity: warning annotations: summary: "High CPU usage on {{ $labels.instance }}" description: "CPU usage is {{ $value }}% on instance {{ $labels.instance }}" 📁 文件组织策略 按功能分类: rule_files: - "rules/system.yml" # 系统监控规则 - "rules/application.yml" # 应用监控规则 - "rules/network.yml" # 网络监控规则 - "alerts/critical.yml" # 严重告警 - "alerts/warning.yml" # 警告告警 按环境分类: rule_files: - "rules/common.yml" # 通用规则 - "rules/production.yml" # 生产环境规则 - "rules/staging.yml" # 测试环境规则 - "rules/development.yml" # 开发环境规则 按团队分类: rule_files: - "rules/platform.yml" # 平台团队 - "rules/application.yml" # 应用团队 - "rules/security.yml" # 安全团队 - "rules/network.yml" # 网络团队 🔍 Glob 模式详解 常用模式: rule_files: # 基础模式 - "rules.yml" # 单个文件 - "rules/*.yml" # rules目录下所有.yml文件 - "rules/**/*.yml" # rules目录及子目录下所有.yml文件 # 高级模式 - "/etc/prometheus/rules/*.yml" # 绝对路径 - "rules/*-rules.yml" # 匹配特定命名模式 - "rules/[a-z]*.yml" # 正则表达式模式 多文件合并: rule_files: - "rules/base.yml" # 基础规则 - "rules/custom/*.yml" # 自定义规则 - "rules/overrides/*.yml" # 覆盖规则 # Prometheus 会按顺序加载所有文件 # 后加载的规则会覆盖同名的录制规则 ⚙️ 实际配置示例 小型环境: rule_files: - "prometheus.rules.yml" 中型环境: rule_files: - "rules/system.yml" - "rules/application.yml" - "alerts/common.yml" 大型环境: rule_files: - "rules/infrastructure/*.yml" - "rules/applications/*.yml" - "rules/security/*.yml" - "alerts/critical/*.yml" - "alerts/warning/*.yml" - "overrides/production/*.yml" 🔧 文件热重载 重载触发: # 发送 SIGHUP 信号重载配置 kill -HUP $(pidof prometheus) # 或者使用 HTTP API curl -X POST http://localhost:9090/-/reload 重载行为: # 重载时会: # 1. 重新解析所有规则文件 # 2. 验证规则语法 # 3. 更新内存中的规则 # 4. 不影响正在运行的抓取 ⚠️ 注意事项 1. 文件路径: # ✅ 相对路径 (相对于配置文件目录) rule_files: - "rules/*.yml" # ✅ 绝对路径 rule_files: - "/etc/prometheus/rules/*.yml" # ❌ 不存在的文件会导致启动失败 rule_files: - "nonexistent.yml" 2. 文件格式: # 支持 YAML 和 YAML 格式 rule_files: - "rules.yml" # ✅ - "rules.yaml" # ✅ - "rules.json" # ❌ 不支持 3. 规则验证: # 使用 promtool 验证规则文件 promtool check rules prometheus.rules.yml # 验证多个文件 promtool check rules rules/*.yml 4. 性能考虑: # 避免过多的小文件 # ❌ 不推荐 rule_files: - "rules/001.yml" - "rules/002.yml" - ... - "rules/100.yml" # ✅ 推荐 rule_files: - "rules/system.yml" - "rules/application.yml" 💡 最佳实践 1. 文件命名规范: # 推荐的命名方式 rules-system.yml rules-application.yml alerts-critical.yml overrides-production.yml 2. 规则组织: # 按逻辑分组,不要把所有规则放在一个文件中 # 每个文件专注一个领域 # 定期清理不使用的规则 3. 版本控制: # 将规则文件纳入版本控制 git add rules/ git commit -m "Add new alert rules" 4. 测试验证: # 在部署前测试规则 promtool check rules rules/*.yml # 测试告警表达式 promtool query instant 'up == 0' 🎯 你的配置分析 你的配置: rule_files: - "prometheus.rules.yml" 这是一个简洁的配置: - ✅ 简单明了: 单个文件包含所有规则 - ✅ 易于管理: 规则集中在一个文件中 - ✅ 适合小规模: 对于中小型部署很合适 如果将来规则增多,可以考虑拆分为多个文件按功能分类管理。

scrape_config_files + scrape_configs

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 227 228 229 230 231 232 233 234 235 236 237 238 239 240 241 242 243 244 245 246 247 248 249 250 251 252 253 254 255 256 257 258 259 260 261 262 263 264 265 266 267 268 269 270 271 272 273 274 275 276 277 278 279 280 1. scrape_config_files - 抓取配置文件 含义: - 指定包含抓取配置的外部文件路径 - 支持 glob 模式匹配 - 从匹配文件中读取抓取配置并追加到主配置中 用途: - 🔧 模块化配置管理 - 🔄 动态配置更新 - 🏗️ 配置文件分离 2. scrape_configs - 抓取配置列表 含义: - 直接在主配置文件中定义抓取配置 - 包含所有监控目标的抓取设置 - 主要的监控配置部分 🔧 配置方式对比 直接配置 (scrape_configs): # prometheus.yml - 传统方式 scrape_configs: - job_name: "prometheus" static_configs: - targets: ["localhost:9090"] - job_name: "node" static_configs: - targets: ["localhost:9100"] 外部文件配置 (scrape_config_files): # prometheus.yml - 主配置文件 scrape_config_files: - "configs/*.yml" - "/etc/prometheus/scrape-configs.d/*.yaml" # configs/prometheus.yml - 外部文件 - job_name: "prometheus" static_configs: - targets: ["localhost:9090"] # configs/node.yml - 外部文件 - job_name: "node" static_configs: - targets: ["localhost:9100"] 🎯 混合使用示例 主配置 + 外部文件: # prometheus.yml global: scrape_interval: 15s evaluation_interval: 1m # 核心配置在主文件中 scrape_configs: - job_name: "prometheus" static_configs: - targets: ["localhost:9090"] # 其他配置从外部文件加载 scrape_config_files: - "configs/services/*.yml" - "configs/infrastructure/*.yml" 📁 文件组织策略 按环境分类: # prometheus.yml scrape_config_files: - "configs/common/*.yml" # 通用配置 - "configs/production/*.yml" # 生产环境 - "configs/staging/*.yml" # 测试环境 按业务分类: scrape_config_files: - "configs/infrastructure/*.yml" # 基础设施 - "configs/applications/*.yml" # 应用服务 - "configs/monitoring/*.yml" # 监控系统 - "configs/security/*.yml" # 安全监控 按团队分类: scrape_config_files: - "configs/platform/*.yml" # 平台团队 - "configs/backend/*.yml" # 后端团队 - "configs/frontend/*.yml" # 前端团队 - "configs/data/*.yml" # 数据团队 🔧 实际配置示例 1. 基础示例: # prometheus.yml scrape_configs: - job_name: "prometheus" static_configs: - targets: ["localhost:9090"] scrape_config_files: - "node-exporter.yml" - "app-metrics.yml" 2. Kubernetes 环境: # prometheus.yml scrape_config_files: - "configs/kubernetes/*.yml" - "configs/services/*.yml" - "configs/infrastructure/*.yml" # configs/kubernetes/pods.yml - job_name: "kubernetes-pods" kubernetes_sd_configs: - role: pod relabel_configs: - source_labels: [__meta_kubernetes_pod_annotation_prometheus_io_scrape] action: keep regex: true 3. 动态配置管理: # prometheus.yml scrape_config_files: - "configs/active/*.yml" # 当前激活的配置 - "configs/templates/*.yml" # 配置模板 # 可以通过脚本动态更新配置文件 # 然后重载 Prometheus 🔄 配置更新机制 文件内容合并: # prometheus.yml scrape_configs: - job_name: "core" static_configs: - targets: ["localhost:9090"] scrape_config_files: - "configs/services/*.yml" # configs/services/web.yml - job_name: "web" static_configs: - targets: ["web1:8080", "web2:8080"] # 最终效果等同于: scrape_configs: - job_name: "core" static_configs: - targets: ["localhost:9090"] - job_name: "web" static_configs: - targets: ["web1:8080", "web2:8080"] 热重载支持: # 重载配置 (包括外部文件) curl -X POST http://localhost:9090/-/reload # 或者发送信号 kill -HUP $(pidof prometheus) 🎯 使用场景 1. 配置分离: # 将配置按模块分离,便于管理 # 不同团队负责各自的配置文件 # 减少主配置文件的复杂度 2. 动态配置: # 通过自动化脚本动态生成配置 # 支持基于服务发现的配置生成 # 便于 CI/CD 集成 3. 环境隔离: # 不同环境使用不同的配置文件 # 主配置保持一致,只替换特定部分 # 支持配置模板化 📊 文件结构示例 /etc/prometheus/ ├── prometheus.yml # 主配置文件 ├── configs/ │ ├── infrastructure/ │ │ ├── node-exporter.yml │ │ ├── cadvisor.yml │ │ └── blackbox-exporter.yml │ ├── applications/ │ │ ├── web-servers.yml │ │ ├── api-servers.yml │ │ └── databases.yml │ └── monitoring/ │ ├── alertmanager.yml │ └── prometheus.yml └── templates/ ├── job-template.yml └── service-template.yml ⚠️ 注意事项 1. 文件格式: # 外部文件只包含抓取配置,不是完整的 Prometheus 配置 # ✅ 正确格式 - job_name: "example" static_configs: - targets: ["host:port"] # ❌ 错误格式 global: scrape_interval: 15s scrape_configs: - job_name: "example" static_configs: - targets: ["host:port"] 2. 文件路径: # 支持相对路径和绝对路径 scrape_config_files: - "configs/*.yml" # 相对路径 - "/etc/prometheus/configs/*.yml" # 绝对路径 3. 重复配置: # 如果出现重复的 job_name,后加载的会覆盖先加载的 # 建议确保 job_name 的唯一性 💡 最佳实践 1. 配置管理: # 使用版本控制管理所有配置文件 # 建立配置文件的命名规范 # 定期清理不使用的配置 2. 文件验证: # 验证配置文件语法 promtool check config prometheus.yml # 测试配置文件 promtool config check prometheus.yml 3. 自动化: # 使用脚本自动生成配置 # 结合服务发现动态更新 # 集成到 CI/CD 流程 🎯 选择建议 使用 scrape_configs 当: - ✅ 配置简单且固定 - ✅ 小规模部署 - ✅ 不需要频繁变更 使用 scrape_config_files 当: - ✅ 配置需要模块化管理 - ✅ 大规模部署 - ✅ 需要动态更新配置 - ✅ 多团队协作 这种配置方式让 Prometheus 的配置管理更加灵活和可扩展,特别适合复杂的生产环境。

alerting